企業で簡単に・安全にLLMを使うために

LLMスターターセットは、企業向けソリューションとして、「Llama 3」「Gemma 2」等の最新の大規模言語モデル(LLM)をインストールした高性能GPU搭載ワークステーションです。

NVIDIA GPUを搭載したエントリーモデルとミッドレンジモデルの2種類をラインナップし、ローカルLLM推奨スペックを満たしています。

さらに、インストールされたLLMの効果的な使い方をサポートするQ&Aチケットも付属しています。このサポートにより、導入初期の疑問や運用上の課題にも迅速に対応でき、安心して運用を開始することができます。

ローカルLLMは、クラウドサービスとは異なり、オンプレミス環境(企業内部のサーバーやワークステーション)で使うため、データが外部に漏れるリスクを大幅に減少させることができます。また、長期的にコスト削減にもつながります。

LLMスターターセットは、企業が生成AI技術を迅速かつ安全に導入し、業務効率化や新たなビジネス展開をサポートします。

LLMスターターセットで、安全なデータ管理と共に、新時代のビジネスを始めましょう!

LLMスターターセット 特長

✓ ローカルLLM検証・運用環境の迅速な立ち上げ

高精度な自然言語処理能力を持つLlama 3やGemma 2などがインストールされており、セットアップ時間を大幅に短縮し、すぐに運用を開始できます。

✓ 安全なデータ管理

オンプレミス環境での運用により、機密データを安全に管理し、外部への漏洩リスクを低減します。

✓ 高性能GPU搭載

GPUの高い演算能力は、LLMモデルがより複雑な計算を正確に実行することを可能にします。

✓ ローカルLLM使い方マニュアルとQ&Aチケット付き

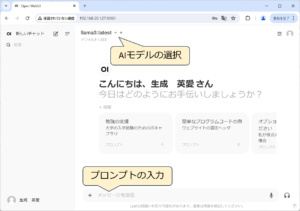

ローカルLLMの推論機能を使用するためのマニュアルをご提供しています。ChatGPTをご利用された方であれば違和感なくご利用可能です。

また、万が一使い方が分からない場合のために、Q&Aチケットをセットにしています。

ローカルLLMが企業に注目される理由

近年、生成AIモデルの進化に伴い、企業は業務効率化や新たなビジネス開発のために生成AIモデルの技術を活用する動きが広まっています。

その中でも、オンプレミス環境で使うローカルLLM(Local Language Model)が特に注目されています。

以下は、その主な理由です。

1. データセキュリティの向上

クラウドサービスとは異なり、ローカルLLMはオンプレミス環境(企業内部のサーバーやワークステーション)で使うため、データが外部に漏れるリスクを大幅に減少させることができます。

特に機密情報や顧客データを扱う企業にとって、データセキュリティは最優先事項です。

2. 低遅延と高パフォーマンス

オンプレミス環境で実行されるため、インターネット接続に依存せず、ネットワークの遅延を抑えることができ、高速な処理が可能です。

これにより、リアルタイムでのデータ処理や応答が必要な業務にも最適です。

3. 運用コストの削減

長期的にはオンプレミス環境でLLMを運用することにより、クラウドサービスの継続的な利用料金を削減し、より高いコスト効率を実現できます。これにより、企業は経済的な運用を行いながら、高性能なAI技術を継続的に活用することが可能です。

ローカルLLMは、製造業や医療分野など、多岐にわたる分野で利用されています。

LLMスターターセット

為替の変動により価格が変更になる場合がありますので、お問い合わせフォームより、お見積をご依頼ください。

【 次の全てに当てはまる方をスターターセットでは想定しています 】

・業務改善でLLMを使いたいが、内部データ漏洩がリスクだと理解されている方

・LLMは万能ではないことを理解されている方

・ローカルLLM環境を構築しようとしている方

・RAGやファインチューニング等の学習機能をすぐに使う予定のない方

【 次に当てはまる方はスターターセットのご購入をお見合わせください 】

・ChatGPT等のLLMサービスを使ったことのない方

・ローカルLLMに社内情報を学習させて、すぐに社内用AIを構築したい方 => お問合せ下さい。

| エントリーモデル | ミッドレンジモデル | |

|---|---|---|

| 参考販売価格 | 1,980,000 円(税抜) | 4,380,000 円(税抜) |

| プレインストールアプリ一覧 | Meta Llama 3 [8Bモデル] Google Gemma 2 [9Bモデル] Microsoft Phi-3 [3.8Bモデル] Ollama Open WebUI | Meta Llama 3 [8B/70Bモデル] Google Gemma 2 [9Bモデル] Microsoft Phi-3 [3.8Bモデル] Ollama Open WebUI |

| LLMスタートアップQ&Aチケット | Q&Aチケット 3 枚付き | Q&Aチケット 6 枚付き |

| ワークステーション | HP Z4 G5 Workstation | |

| GPU | NVIDIA RTX 4500 Ada [24GB] × 1基 | NVIDIA RTX 6000 Ada [48GB] × 1基 |

| CPU | インテル Xeon w3-2423プロセッサー (2.1GHz 最大4.2GHz / 6コア / 15MB / 4400MHz) | インテル Xeon w5-2445 プロセッサー (3.1GHz 最大4.6GHz / 10コア / 26.25MB / 4800MHz) |

| システムメモリ* | 64GB DDR5 SDRAM (4800MHz / ECC / Registered / 16GBx4) | 128GB DDR5 SDRAM (4800MHz / ECC / Registered / 32GBx4) |

| SSD* | 1TB HP Z Turboドライブ G2 (内蔵M.2スロット接続 TLC NVMe SSD) | 2TB HP Z Turboドライブ G2 (内蔵M.2スロット接続 TLC NVMe SSD) |

| HDD* | 4TBハードディスクドライブ (SATA / 7200rpm) | |

| OS | Ubuntu | |

| 光 学ドライブ | DVD-RW | |

| キーボード、マウス | 標準添付 | |

| モニター | なし | |

| 保守 | 3年間翌日オンサイト(休日修理付き) GPUに関してはセンドバック保証3年 | |

| 筐体サイズ | 幅 169 mm × 奥行 445 mm × 高さ 386 mm | |

| 消費電力 | 775 W (80PLUS認証電源ユニット、90%変換効率) | |

* システムメモリ、SSD、HDDは増設することができます。

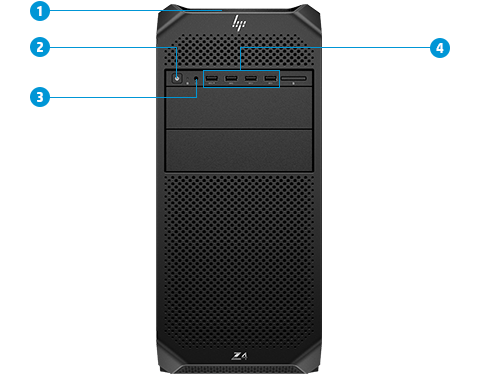

HP Z4 G5 Workstation

HP Z4 G5 Workstationは、卓越した性能と拡張性を兼ね備えたプロフェッショナル向けのワークステーションです。

最新のIntel Xeonプロセッサを搭載し、高度な計算を要求するタスクもスムーズにこなします。

最大256GBのメモリと複数のストレージオプションにより、大容量のデータ処理も快適です。多彩なI/Oポートと拡張スロットで、様々な周辺機器やカードを簡単に接続できます。

信頼性の高い冷却システムと堅牢なシャーシ設計により、長時間の稼働にも耐える優れた耐久性を誇ります。

HP Z4 G5 Workstationは、クリエイティブプロフェッショナルやエンジニアに最適な、卓越したパフォーマンスを提供する一台です。

- フロントハンドル

- 電源ボタン

- オーディオジャック

- USB3.1 Gen1 Type-A × 4

5. 電源ボタン

6. オーディオライン

7. 1GbE イーサネットスタンダードポート×1

8. USB3.1 Gen1 Type-A ×6

9. リアハンドル

10. 電源コネクタ

NVIDIA RTX GPU

NVIDIA RTX は、AI・ディープラーニング、デザインや設計などのCAD制作、3DCG、映像編集、VRなど、プロフェッショナル向けのGPUです。

NVIDIA RTX は、負荷の高い処理を長時間、稼働できるように設計されています。

LLMスタートアップサービス

LLMスターターセットはプロメテック・ソフトウェアがご提供する「LLMスタートアップサービス」、「LLMスタートアップQ&Aチケット」とGDEPが販売するGPUワークステーションをセット化し、お求めやすい価格でご提供するプレインストールモデルです。

「LLMスタートアップサービス」は、最新のローカルLLMやChatGPTライクなユーザインターフェース、ローカルLLMを使いこなすためのフレームワークなどの公開された無償アプリケーションをお客様に代わって選定し・インストールする構築サービスです。

また、ローカルLLMを利用開始するまでのユーザマニュアル※1も同梱します。

「LLMスタートアップQ&Aチケット」は、ユーザマニュアルでは分からない場合に気軽にQ&Aができるチケットとなります※2。

このチケットにより、導入初期の疑問点や運用中の課題に迅速に対応できるため、ローカルLLMの導入がスムーズに進みます。

※1 ユーザマニュアルは、プレインストールされたローカルLLMをChatGPTのように使うための簡単なマニュアルです。RAGやファインチューニングの記述は含まれていませんが、Open WebUIのRAG機能を利用することは可能です。

※2 Q&Aチケットの対応範囲はLLMスタートアップサービスで構築した環境とユーザマニュアルまでとなります。RAGやファインチューニングの範囲はQ&Aの対象外となっていますので、ご注意ください。

| エントリーモデル | ミッドレンジモデル | |

|---|---|---|

| プレインストールアプリ一覧 | Meta Llama 3 [8Bモデル] Google Gemma 2 [9Bモデル] Microsoft Phi-3 [3.8Bモデル] Ollama Open WebUI | Meta Llama 3 [8B/70Bモデル] Google Gemma 2 [9Bモデル] Microsoft Phi-3 [3.8Bモデル] Ollama Open WebUI |

| LLMスタートアップQ&Aチケット | Q&Aチケット 3 枚付き | Q&Aチケット 6 枚付き |

用語解説

- Meta Llama 3 [8Bモデル]

Meta Llama 3 [8Bモデル]は、約80億のパラメータを持つエントリーレベルの大規模言語モデルです。高性能GPUと組み合わせることで、自然言語処理タスクに対して迅速で高精度な応答を提供し、ビジネスのデータ分析やコンテンツ生成など、幅広い用途に対応します。コストパフォーマンスに優れ、初めてのLLM導入に最適です。 - Meta Llama 3 [70Bモデル]

Meta Llama 3 [70Bモデル]は、約700億のパラメータを持つ大規模言語モデルです。高い計算能力と精度を誇り、複雑な自然言語処理タスクや多言語対応、専門的なリサーチ分析に最適です。高性能GPUと組み合わせることで、大規模なデータ処理とリアルタイム応答を実現し、ビジネスの高度なニーズに応えます。 - Google Gemma2

Google Gemma2は、Googleが開発した高性能な大規模言語モデルで、自然言語処理の精度と効率を追求しています。最新のアルゴリズムと大量のトレーニングデータにより、高度なテキスト生成、データ分析、会話型AIに最適です。企業の業務効率化や新しいビジネスソリューションの開発に役立ちます。 - Microsoft Phi-3

Microsoft Phi-3は、Microsoftが提供する高度な大規模言語モデルで、強力な自然言語処理能力を持ちます。文書の理解、生成、要約、翻訳など、多様なタスクに対応可能です。企業のデジタルトランスフォーメーションを加速し、効率的なデータ分析やカスタマーサービスの向上を支援します。 - Ollama

Ollamaは、オープンソースの自然言語処理モデルで、広範なコミュニティによって開発および改善されています。高い柔軟性とカスタマイズ性を持ち、特定のビジネスニーズに合わせたモデルの調整が可能です。小規模から大規模なプロジェクトまで、様々な環境で効果的に利用できます。 - Open WebUI

Open WebUIは、オープンソースのユーザーインターフェースフレームワークで、自然言語処理モデルの操作性を向上させます。使いやすいインターフェースにより、モデルのトレーニング、評価、デプロイを容易に行うことができ、開発者やデータサイエンティストにとって効率的なツールです。 - RAG(Retrieval-Augmented Generation)

RAGは、生成モデルと検索モデルを組み合わせた技術で、より正確で豊富な情報を生成することができます。質問応答やドキュメント要約などのタスクで、外部知識ベースから関連情報を検索し、それを基に高品質な応答を生成します。これにより、知識の幅広さと応答の信頼性が向上します。 - ファインチューニング

ファインチューニングは、事前にトレーニングされた大規模言語モデルを特定のタスクやデータに合わせて再調整するプロセスです。これにより、特定の業界や用途に最適化されたモデルが得られ、精度とパフォーマンスが向上します。カスタマイズされた応答や予測が可能となり、企業のニーズに応じた高い適応性を提供します。

見積依頼・お問い合わせはこちら

製品に関するご質問・ご相談など、お気軽にお問い合わせください。

NVIDIA認定のエリートパートナー「GDEPソリューションズ」は、

お客様の用途に最適な製品のご提案から導入までサポートします。