2022年3月21日-24日開催のNVIDIA GTC 2022で、NVIDIA社の新しいGPUアーキテクチャNVIDIA Hopper 採用の「NVIDIA H100 GPU」が発表され、そのH100 GPU が8基搭載された「NVIDIA DGX™ H100」も同時に発表されました。

NVIDIAのエリートパートナーであるGDEPソリューションズは、「NVIDIA DGX H100」の販売を行なっています。

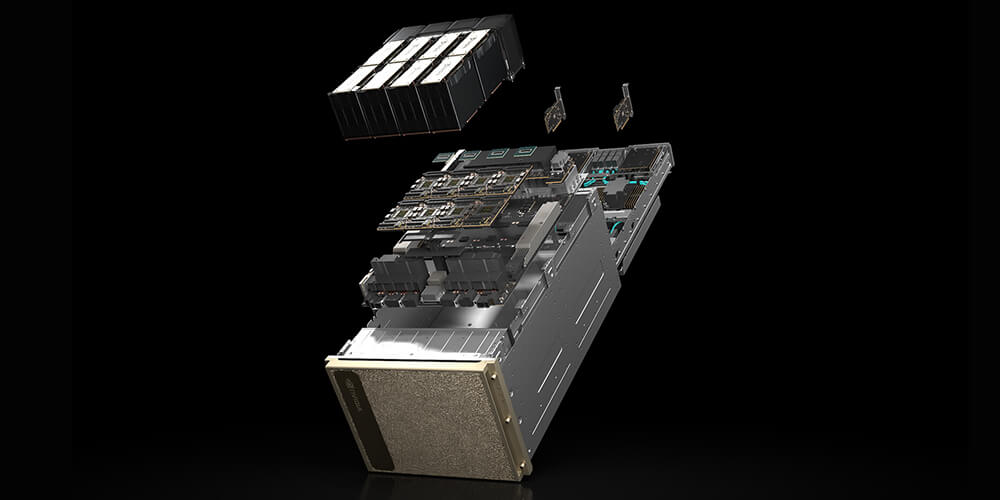

NVIDIA DGX H100

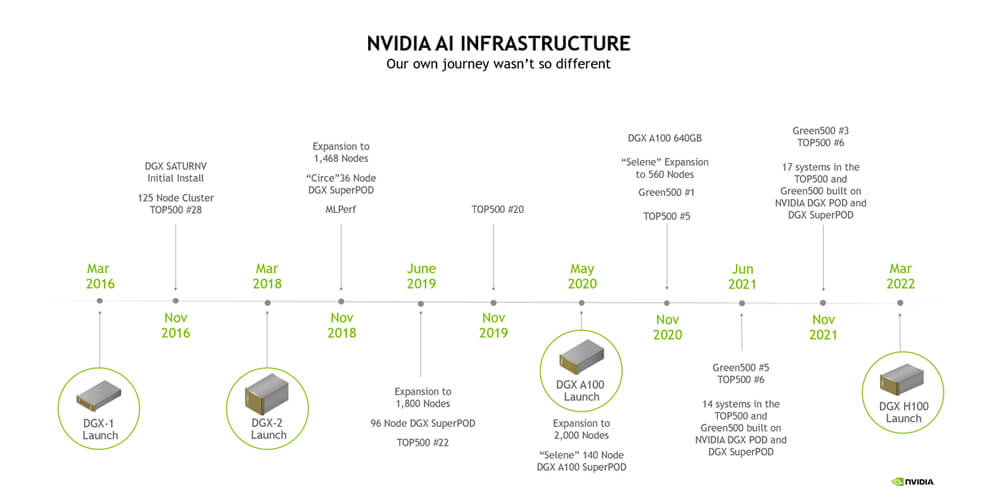

NVIDIA社は、NVIDIA H100 Tensor Core GPUを搭載した世界初のAIプラットフォーム、DGXシステム第4世代となる「NVIDIA DGX H100」を2022年に発表しました。

8基のNVIDIA H100 GPUを搭載したNVIDIA DGX H100は、NVIDIA NVLinkで1つに接続されており、新しいFP8精度で前世代のDGX A100の6倍以上に相当する「32ペタフロップス」のAI性能と高速化を実現しました。

NVIDIA DGX H100は、世界で初めてNVIDIA H100 Tensor Core GPUを搭載したシステムであり、AIのスケールとパフォーマンスの限界を突破します。

NVIDIA ConnectX®-7スマートネットワークインターフェイスカード(SmartNIC)と、NVIDIA BlueField®-3データプロセシングユニット(DPU)で6倍のパフォーマンスと2倍高速なネットワーキングを実現し、DGX SuperPOD向けのハイスピードスケーラビリティを提供します。

この次世代アーキテクチャは、自然言語処理やディープラーニングによるレコメンデーションモデルなど、大規模で複雑なAIジョブに対応できるように強化されています。

NVIDIA DGX H100は、オンプレミスに導入して直接管理できるほか、NVIDIA DGX対応のデータセンターへのコロケーション、NVIDIA DGX Foundryでのレンタル、NVIDIA認定のマネージドサービスプロバイダーを介した利用が可能です。

また、DGX対応のライフサイクル管理プログラムにより、最新のシステム導入を維持するための予測性の高い財務モデルを利用できます。これを利用すると、忙しいITスタッフの負担を増やすことなく、従来のITインフラと同じように簡単にNVIDIA DGX H100を活用できるため、明日を待たずにビジネスに取り入れることができます。

2023年3月 出荷開始

NVIDIA DGX H100 特徴

1. 強力なハードウェア構成

NVIDIA H100 Tensor Core GPU

NVIDIA DGX H100 は、最新のNVIDIA H100 Tensor Core GPUを8基搭載しています。

GPUメモリ 640GB

NVIDIA DGX H100 は、NVIDIA H100 GPU [80GB] × 8基 = 640GBの大容量GPUメモリを搭載しています。

8基のGPUはNVIDIA NVLinkで高速接続され、GPU 間の双方向帯域幅は 900GB/秒 を実現しました。

NVIDIA NVSwitch™

NVIDIA DGX H100 は、NVSwitch × 4により前世代の1.5倍となる、7.2テラバイト/秒の双方向GPU-GPU帯域幅を実現。シームレスなパフォーマンスを提供します。

システムメモリ

NVIDIA DGX H100 は、デュアル × 86CPUと、2テラバイトのシステムメモリが搭載されています。

ストレージ

NVIDIA DGX H100 は、最大のパフォーマンスを実現する高速ストレージ 30TB NVMe SSDを搭載。

2. 卓越したAI性能

FP8精度

NVIDIA DGX H100は、新しいFP8精度により、前世代のDGX A100の6倍以上の「32ペタフロップス」という高いAI性能を実現しました。

多様なAIワークロードに対応

ディープラーニング、自然言語処理、大規模レコメンデーションモデルなど、複雑なAIジョブを高速に処理することができます。

3. 高度なネットワーキング機能

NVIDIA ConnectX®-7 SmartNIC

パフォーマンスを6倍向上させ、ネットワーキング速度を2倍にするスマートネットワークインターフェイスカード「NVIDIA CONNECTX-7 SmartNIC」がNVIDIA DGX H100に搭載されています。

NVIDIA BlueField®-3 DPU

NVIDIA BlueField-3 DPUの高性能なデータプロセシングユニットで、ネットワーク機能がさらに強化され、ピーク時の双方向ネットワーク帯域幅 1TB/秒を実現しました。

4.スケーラビリティと柔軟性

NVIDIA DGX SuperPOD対応

NVIDIA DGX H100 は、次世代 NVIDIA DGX POD および NVIDIA DGX SuperPOD といったAIデータセンター インフラストラクチャプラットフォームを構成することが可能です。

NVIDIA DGX SuperPODは、きわめて困難な AI およびハイパフォーマンス コンピューティング (HPC) ワークロードに対して、最高クラスのアクセラレーテッド インフラストラクチャと俊敏かつスケーラブルなパフォーマンスを提供し、業界で認められた結果をもたらします。

NVIDIA DGX H100 スペック

NVIDIA DGX H100 と、前世代となる NVIDIA DGX A100 のスペックを比較してみましょう。

| NVIDIA DGX H100 | NVIDIA DGX A100 | |

| GPU | NVIDIA H100 Tensor Core GPU 80 GB x 8基 | NVIDIA A100 Tensor Core GPU 80 GB x 8基 |

| GPUメモリ | Total 640 GB | Total 640 GB |

| 性能 | 32 petaFLOPS FP8 | AIで 5 petaFLOPS INT8で 10petaFLOPS |

| NVIDIA NVSwitches | 4x | 6 |

| CPU | Dual x86 | Dual AMD Rome 7742 2.25 GHz(base), 3.4 GHz(max boost) Total 128 コア |

| システムメモリ | 2 TB | 2 TB |

| ネットワーク | 4 個の OSFP ポートで 8 基の シングルポート ConnectX-7 へ接続 400Gb/s InfiniBand/Ethernet 2 基のデュアルポート NVIDIA BlueField-3 DPU VPI 400Gb/s InfiniBand/Ethernet x1 200Gb/s InfiniBand/Ethernet x1 10Gb/s オンボード NIC(RJ45 付き) 50Gb/s Ethernet オプション NIC ホスト ベースボード管理コントロー ラー(BMC)(RJ45 付き) 2x NVIDIA BlueField-3 DPU BMC (それぞれ RJ45 コネクタで接続) | Single-Port Mellanox ConnectX-6 VPI 200Gb/s HDR InfiniBand × 8 Dual-Port Mellanox ConnectX-6 VPI 10/25/50/100/200 Gb/s Ethernet × 2 |

| ストレージ | OS: 1.92 TB M.2 NVMe E drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives | OS: 1.92 TB M.2 NVMe drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives |

| ソフトウェア | DGX H100システムには、Ubuntu Linuxに基づいて DGXソフトウェアスタック (DGX用に最適化されたすべての必要なパッケージとドライバー) を含むDGX OSがプリインストールされています。 オプションで、お客様はUbuntu LinuxまたはRedHat EnterpriseLinuxと 必要なDGXソフトウェアスタックを個別にインストールできます。 | Ubuntu Linux OS Red Hat Enterprise Linux 7,8 / CentOS 7,8 |

| 最大消費電力 | 10.2 kW max | 6.5 kW max |

| 運用温度範囲 | 5 ℃ - 30 ℃ | 5 ℃ - 30 ℃ |

| サイズ | 高さ:356 mm 幅:482.2 mm 奥行:897.1 mm 130.45 kg | 高さ: 264.0 mm 幅: 482.3 mm 奥行: 897.1 mm 123.16 kg |

*スペックは予告なく変更される場合があります。

NVIDIA DGX H100 価格

教育機関、NVIDIA Inceptionパートナー、一般企業・研究機関向けの価格がございます。

また、3年間のNVIDIA DGX システム エンタープライズ サポートのご購入が必要です。(サポート期間は4年、5年も選択可能です。)

詳しくはお問い合わせ下さい。

見積依頼・お問い合わせはこちら

製品に関するご質問・ご相談など、お気軽にお問い合わせください。

NVIDIA認定のエリートパートナー「GDEPソリューションズ」は、

お客様の用途に最適な製品のご提案から導入までサポートします。