NVIDIA DGX™ H200 は、AI 対応の高性能製品であり、企業のビジネスイノベーションと最適化を支援します。

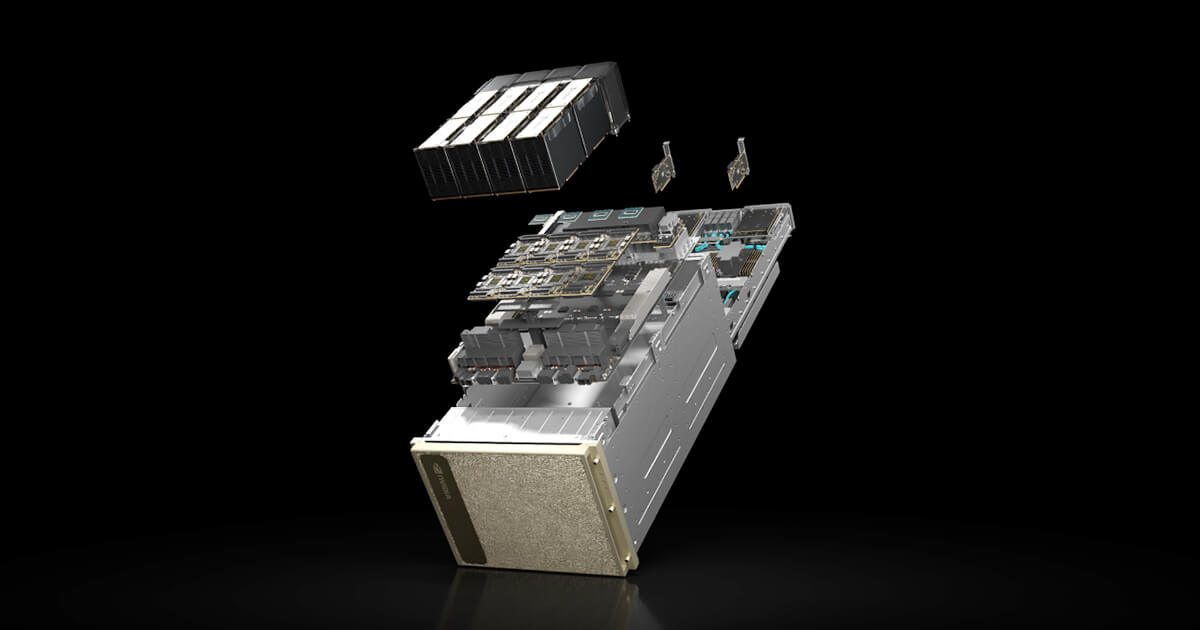

NVIDIA DGX H200は、生成AI、自然言語処理、ディープラーニングなどの大規模なワークロードに対応するため、合計1,128GBという広大なGPUメモリを備えています。

141GBのGPUメモリ「NVIDIA H200 TensorコアGPU」が8基搭載されています。

その画期的なパフォーマンスにより、これからの先端技術を効率的にサポートします。

また、NVIDIA DGX H200は、AIのスループットを最大化するよう設計されており、自然言語処理、レコメンダーシステム、データ分析などの分野で企業が画期的な成果を達成するための、高度に洗練されたスケーラブルなプラットフォームを提供します。このシステムにより、企業は革新的なAIソリューションを迅速かつ効率的に実現できます。

人工知能(AI)は、難しいビジネス課題を解決するための主要なアプローチとなっています。

顧客サービスの向上、サプライチェーンの最適化、ビジネスインテリジェンスの抽出、生成AIやその他のトランスフォーマーモデルを用いた最先端の製品やサービスの設計など、AIはほぼすべての業界でイノベーションを実現する手段として使われています。

NVIDIA DGX H200 は、NVIDIA H200 Tensor コア GPU の画期的なパフォーマンスにより高速化された、AI 対応の高性能GPUシステムです。

NVIDIA DGX H200 を導入して、AI の未来を切り開きましょう!

★ 出荷開始までにスペック、価格、サポート内容等は変更される場合があります。ご了承ください。

NVIDIA DGX H200

主な特徴

1. 圧倒的なGPUメモリとパフォーマンス

・141GBのメモリを持った「NVIDIA H200 TensorコアGPU」を8基搭載し、合計1,128GBのGPUメモリを実現。大規模なデータセットを効率的に処理します。

・32 petaFLOPS の AI パフォーマンスを提供し、前世代と比較して2倍の速度を実現

2. 高度なスケーラビリティ

・AIのスループットを最大化するために設計された高度にスケーラブルなシステム

・高速ネットワークとスケーラビリティにより、AI スケーリングの障壁を打ち破ります。

3. 完全統合型ソリューション

・NVIDIA Base Command™ や NVIDIA AI Enterprise ソフトウェア スイートが含まれ、専門家のサポートを受けることができます

・これにより、企業は最も大きく複雑なビジネス問題をAIで解決することができます。

技術仕様

GPU:

NVIDIA H200 GPU×8基搭載、合計 GPU メモリ 1,128GB

ネットワーク:

10 x NVIDIA ConnectX®-7、400Gb/秒のネットワークインターフェイス

プロセッサ:

デュアル Intel Xeon Platinum 8480C プロセッサ、合計 112 個のコア

ストレージ:

30TB NVMe SSD、最高のパフォーマンスのための高速ストレージ

NVIDIA DGX H200

AIセンターオブエクセレンスの第一歩

NVIDIA DGX H200 を使って、AIセンターオブエクセレンスを構築しましょう。

DGX H200 は、NVIDIA Base Command™ や NVIDIA AI Enterprise ソフトウェアスイートを含む、完全統合型のハードウェアおよびソフトウェアソリューションです。また、NVIDIA DGXperts から専門家のアドバイスを受けることもできます。

AIスケーリングの障壁を打ち破る

NVIDIA DGX H200 アーキテクチャは、32 petaFLOPS のAIパフォーマンスを提供し、前世代と比較して2倍の速度を誇るネットワークと高速なスケーラビリティを備えています。

このソリューションは、生成AI、自然言語処理、ディープラーニングによるレコメンデーションモデルなど、大規模なワークロードに対応できるよう強化されています。

リーダーシップクラスのインフラを思いのままに

NVIDIA DGX H200 のパワーを、オンプレミス、コロケーション、またはマネージドサービスプロバイダーからのレンタルなど、さまざまな方法で体験しましょう。

さらに、DGX対応のライフサイクル管理により、組織は予測可能な財務モデルを手に入れ、最先端のデプロイを維持することができます。

NVIDIA DGX H200

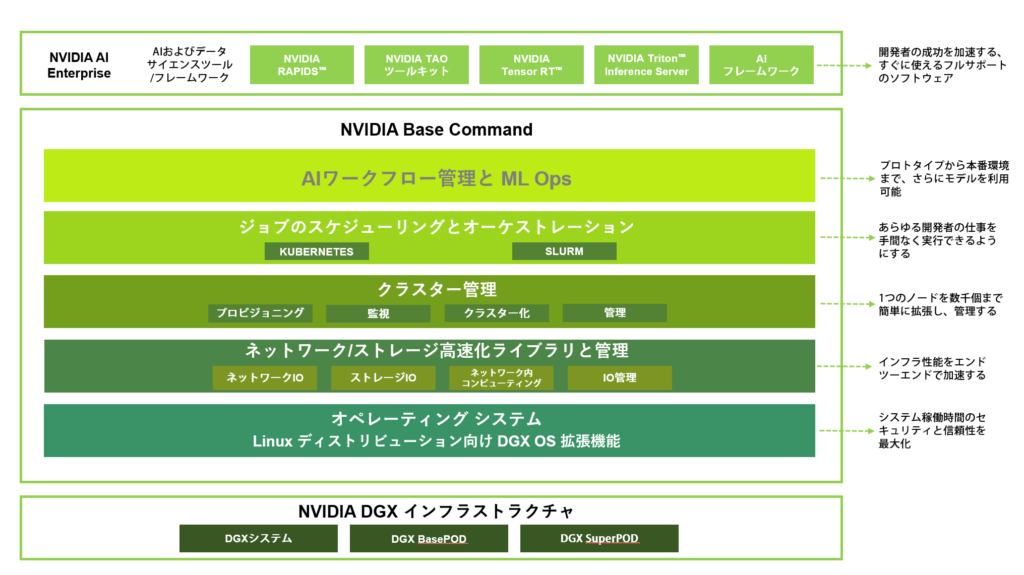

実証済みインフラ標準 / NVIDIA Base Command 搭載

NVIDIA Base CommandはDGXプラットフォームを強力にサポートし、組織がNVIDIAの最新ソフトウェアイノベーションを最大限に活用できるようにします。

企業は、エンタープライズグレードのオーケストレーションとクラスタ管理、計算、ストレージ、ネットワークインフラを加速するライブラリ、およびAIワークロードに最適化されたオペレーティングシステムを含む実証済みのプラットフォームを通じて、DGXインフラのフルポテンシャルを引き出すことができます。

さらに、DGXインフラには、AIの開発と展開を簡素化するために最適化されたソフトウェアスイートであるNVIDIA AI Enterpriseが含まれています。

NVIDIA DGX H200 スペック

「NVIDIA DGX H200」と、NVIDIA DGXシリーズ「NVIDIA DGX B200」、「NVIDIA DGX H100」、「NVIDIA DGX A100」のスペックを比較してみましょう。

| NVIDIA DGX H200 | NVIDIA DGX B200 | NVIDIA DGX H100 | NVIDIA DGX A100 | |

| GPU | NVIDIA H200 Tensor Core GPU × 8基 | NVIDIA Blackwell GPU × 8基 | NVIDIA H100 Tensor Core GPU × 8基 | NVIDIA A100 Tensor Core GPU × 8基 |

| GPUメモリ | Total 1,128 GB | Total 1,440 GB | Total 640 GB | Total 640 GB |

| 性能 | 32 petaFLOPS FP8 | 72 ペタ FLOPSトレーニング 144 ペタ FLOPS 推論 | 32 petaFLOPS FP8 | AIで 5 petaFLOPS INT8で 10petaFLOPS |

| NVIDIA NVSwitches | 4 | 2 | 4 | 6 |

| CPU | Dual Intel® Xeon® Platinum 8480C プロセッサ (合計112コア、2.0 GHz (ベース)、3.8 GHz (最大ブースト) | Dual Intel® Xeon® Platinum 8570 プロセッサ (合計 112 コア)、2.1 GHz (ベース)、 4 GHz (最大ブースト) | Dual Intel® Xeon® P latinum 8480C プロセッサ(合計 112 コア)、2.0 GHz (ベース)、3.8 GHz (最大ブースト) | Dual AMD Rome 7742 2.25 GHz(base), 3.4 GHz(max boost) Total 128 コア |

| システムメモリ | 2 TB | 4 TB | 2 TB | 2 TB |

| ネットワーク | 4 個の OSFP ポートで 8 基のシングル ポート NVIDIA ConnectX-7 VPI > 400 Gb/秒の InfiniBand/Ethernet 2 基のDual-Port QSFP112 NVIDIA ConnectX-7 VP I > 400 Gb/秒のInfiniBand/Ethernet 10 Gb/秒 オンボード NIC(RJ 45 搭載) 100 Gb/秒のEthernet NIC ホスト ベースボード管理コントローラー (BMC)(RJ 45 搭載) | 4 個の OSFP ポートで 8 個のシングルポートNVIDIA ConnectX-7 VPI > 400 Gb/秒の InfiniBand/Ethernet 2 基のDual-Port QSFP112 NVIDIA BlueField-3 DPU > 400 Gb/秒の InfiniBand/Ethernet 10 Gb/秒 オンボード NIC (RJ45 搭載) 100 Gb/秒のDual-Port Ethernet NIC ホスト ベースボード管理コントローラー (BMC)(RJ 45 搭載) | 4 個の OSFP ポートで 8 基のシングル ポート NVIDIA ConnectX-7 VPI > 400 Gb/秒の InfiniBand/Ethernet 2 基のDual-Port QSFP112 NVIDIA ConnectX-7 VP I > 400 Gb/秒のInfiniBand/Ethernet 10 Gb/秒 オンボード NIC(RJ 45 搭載) 100 Gb/秒のEthernet NIC ホスト ベースボード管理コントローラー (BMC)(RJ 45 搭載) | Single-Port Mellanox ConnectX-6 VPI 200Gb/s HDR InfiniBand × 8 Dual-Port Mellanox ConnectX-6 VPI 10/25/50/100/200 Gb/s Ethernet × 2 |

| ストレージ | OS: 1.9 TB M.2 NVMe drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives | OS: 1.9 TB M.2 NVMe drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives | OS: 1.92 TB M.2 NVMe E drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives | OS: 1.92 TB M.2 NVMe drives × 2 内部ストレージ:30 TB (3.84 TB × 8) U.2 NVMe drives |

| ソフトウェア | NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command - オーケストレーショ ン、スケジューリング、クラスタ管理 DGX OS / Ubuntu / Red HatエンタープライズLinux / Rockyオペレーティングシステム | NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command - オーケストレーショ ン、スケジューリング、クラスタ管理 DGX OS / Ubuntu | NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command - オーケストレーショ ン、スケジューリング、クラスタ管理 DGX OS / Ubuntu | Ubuntu Linux OS Red Hat Enterprise Linux 7,8 / CentOS 7,8 |

| 最大消費電力 | 最大 10.2 kW | 最大 14.3 kW | 最大 10.2 kW | 最大 6.5 kW |

| 運用温度範囲 | 5 ℃ - 30 ℃ | 5 ℃ - 30 ℃ | 5 ℃ - 30 ℃ | 5 ℃ - 30 ℃ |

| サイズ | 高さ: 356mm 幅: 482.2mm 奥行: 897.1mm 130.45kg | 高さ: 442 mm 幅: 482.6 mm 奥行: 907.8 mm 142.38 kg | 高さ:356 mm 幅:482.2 mm 奥行:897.1 mm 130.45kg | 高さ: 264.0 mm 幅: 482.3 mm 奥行: 897.1 mm 123.16 kg |

企業向けサポート

・ハードウェアとソフトウェアの 3 年間のエンタープライズ Business-Standardサポート

・年中無休のエンタープライズ サポート ポータル アクセス

・現地営業時間中のライブ エージェント サポート

* スペックは予告なく変更される場合があります。

NVIDIA DGX H200 価格

教育機関、NVIDIA Inceptionパートナー、一般企業・研究機関向けの価格がございます。

また、3年間の企業向けサポートのご購入が必要になります。

(サポート期間は4年、5年も選択可能です。)

詳しくはお問い合わせ下さい。

★ 出荷開始までにスペック、価格、サポート内容等は変更される場合があります。ご了承ください。

見積依頼・お問い合わせはこちら

製品に関するご質問・ご相談など、お気軽にお問い合わせください。

NVIDIA認定のエリートパートナー「GDEPソリューションズ」は、

お客様の用途に最適な製品のご提案から導入までサポートします。