[No.29] Facebookは人間の日常生活でAIを教育、ARグラスに搭載しアルゴリズムが利用者の視覚や聴覚をエンハンス

Facebookは人間の視線で周囲の状況を把握するAIの研究を開始した。

このプロジェクトは「Ego4D」と呼ばれ、人間の視線で捉えたデータ(下の写真)でアルゴリズム教育することで、AIは実社会でインテリジェントな能力を発揮する。

これをARグラスやVRヘッドセットに搭載することで、AIがアシスタントとなり利用者の視覚や聴覚をエンハンスする。また、これをロボットに搭載すると、実社会で自律的に稼働する機能を得ることができる。

当事者の視点で環境を理解

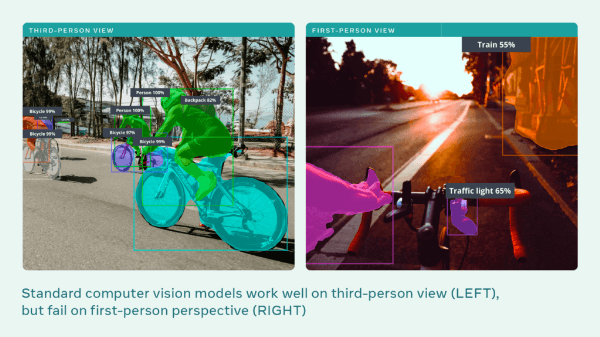

コンピュータビジョンの進化でAIはオブジェクトを認識しその種別を正確に判定する。しかし、これらのAIは第三者視点(third-person perspective、下の写真左側)で開発されたもので、傍観者としてオブジェクトを判定する。

これに対し、Facebookは第一者視点(first-person perspective、右側)でアルゴリズムを教育する研究を開始した。

この技法は「Egocentric Perception」と呼ばれ、開発されたAIは当事者の視点でオブジェクトを判定できるようになる。これをARグラスやVRヘッドセットに搭載すると、AIがアシスタントとして周囲の状況を把握し最適な助言を行う。

また、ロボットへ適用すると、AIが視覚となり実社会の中を自律的に稼働するシステムにつながる。(下の写真はサイクリングに関する画像認識の判定結果。第三者視点で開発されたAIの判定精度は高いが(左側)、第一者視点で開発されたAIの判定精度はまだ低い(右側)。)

開発したAIの利用方法

FacebookはARグラスの開発を進めており、その第一弾としてスマートグラス「Ray-Ban Stories」を発表した。

これから製品化されるARグラスには第一者視点のAIが搭載され、インテリジェントなアシスタントとして使われる。AIが周囲のオブジェクトを見てその種別などを把握する。

例えば、ARグラスで日常生活を録画しておくと、AIはこれを解析して利用者の質問に回答する。「祖母の腕時計をどこに片づけた」と質問すると、AIは過去のビデオを解析し、ARグラスにその場所を表示する(下の写真)。

大学との共同開発

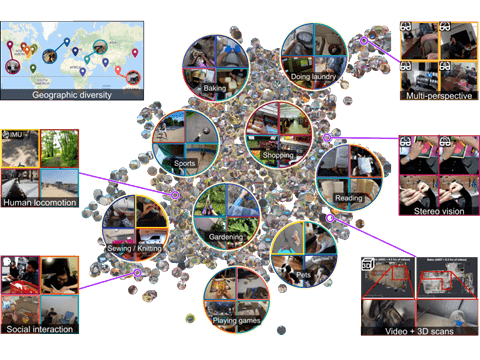

利用者の視点でオブジェクトを判定するAIを開発するためには、アルゴリズムを教育するための大量のデータが必要になる。

このため、Facebookは各国の大学と共同研究をすすめ、利用者視点のデータを集約して教育のためのデータセットを開発している(下の写真)。世界から13の大学が参加しているが、日本からは東京大学がこのプロジェクトに加わっている。

データセットの構成

開発者はスマートグラスなどを着装してカメラで日常生活を録画する。これら録画されたビデオにその意味を付加して、生活の中での動きとその説明文のペアを作る。

これらのビデオを集約したデータセットを構築し、これらのデータを使ってAIを教育するプロセスとなる。

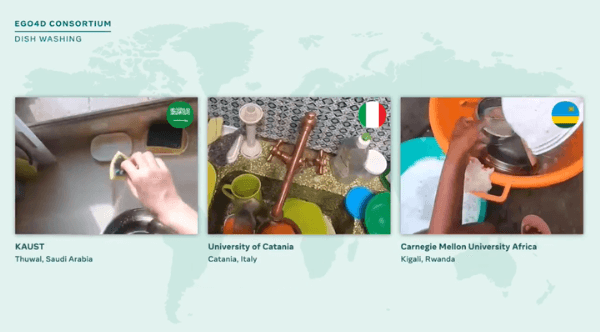

日常生活の様式は国により異なり、Facebookは主要国の大学と共同でこれを進めている。(下の写真;皿洗いを撮影したビデオで、左からサウジアラビア、イタリア、ルワンダの事例となる。)

アルゴリズム教育

次は、生成したデータセットを使ってアルゴリズムを教育するステップとなる。ここがAI開発のコアで、Facebookはこれを研究課題として提示し、大学や研究機関の研究者がこれに挑戦する形式をとる。チャレンジは五つのテーマから構成される。

- イベントの記憶(Episodic memory): AIはいつどこで何があったかを把握。(上述の事例の通り、祖母の腕時計をどこに格納したかを把握。)

- 予測(Forecasting): AIはビデオをみて次のアクションを予測。

- 手作業(Hand and object manipulation): AIは手の動きからどんな作業をしているかを把握。(ドラムを演奏する方法を把握し、それを教える(下の写真)。)

- 音声映像の記録(Audio-visual diarization): AIはだれが何を言ったかを把握。

- 人間関係(Social interaction): AIは誰と誰が会話しているかなど人間関係を把握。

AIビジョンの進化

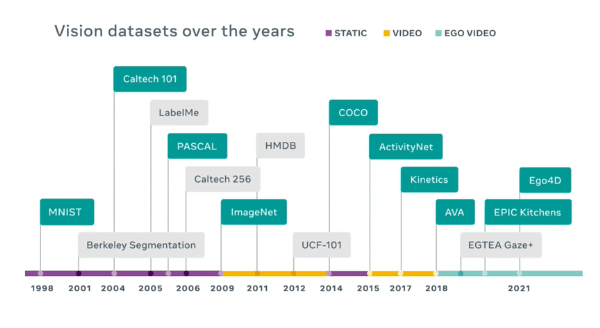

AI開発でオブジェクトの形状を把握するコンピュータビジョンが急成長しているが、アルゴリズムを教育するためのデータセットが技術進化を支えている(下の写真)。

AI開発の初期には手書き文字を判読するためのデータセット「MNIST」が開発された。コンピュータビジョンが急速に進化したのは、イメージのデータセット「ImageNet」の存在が大きい。ここには大量の写真とタグが格納され、これによりAIが人間の視覚を上回った。これらはすべて第三者視点のデータセットで、Ego4Dが第一者視点の最初のデータセットとなる。