[No.101]GPT-4とChatGPTの開発手法の秘密が明らかになる、最大の課題は信頼できるAIモデルの開発、NVIDIA開発者会議におけるOpenAIとの対談から

NVIDIAは開発者会議「GTC 2023」を開催し、CEOのJensen Huang(下の写真左側)はOpenAIの共同創設者であるIlya Sutskever(右側)と対談し、大規模言語モデルとAIスパコンに関し意見を交わした。

Sutskeverは対談の中で、GPT-4とChatGPTの開発手法について、その内幕を開示し、また、これからの開発方向について触れた。

OpenAIの高度なAIはMicrosoft Azureで開発されており、ここにNVIDIAのGPU最新モデルが使われている。

OpenAIとは

大規模言語モデルChatGPTが社会にインパクトを与えているが、このAIはサンフランシスコのスタートアップ企業OpenAIで開発された。

OpenAIは2015年に、Sam Altman、Ilya Sutskever、Elon Muskらにより設立された。

その後、2018年、Muskは開発戦略に異を唱え、会社を去り、ChatGPTなどの開発には関わっていない。

現在、Sam AltmanがCEOを、Ilya SutskeverがCSO(Chief Science Officer)を務めている。

Sam Altmanの人物像

Elon Muskのプロフィールはよく知られているが、Sam AltmanとIlya Sutskeverについては知名度が低い。

Altmanはスタートアップ企業を興し、その後、インキュベーター「Y Combinator」でCEOを務めた。

そののちに、OpenAIを創設し、CEOとして会社の運営に携わっている。

AltmanはAIがもたらす危険性と富の分配の偏りに懸念を抱いており、個人の資金を使ってベーシックインカム(Universal Basic Income)の実証試験を展開した。

Ilya Sutskeverとは

Iliya Sutskeverに関しては知名度は殆ど無いが、OpenAIの研究開発の総責任者として、ChatGPTなどの開発を指揮してきた。

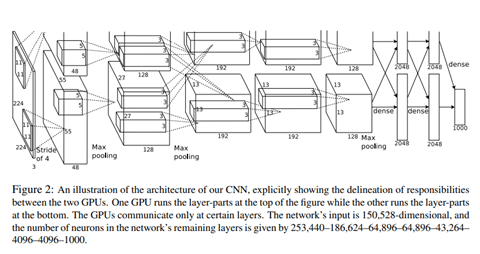

Sutsukeverは2012年に、画像を判定する技術にニューラルネットワークを適用することで、判定精度を劇的に改良した。

このモデルは「AlexNet」と呼ばれ、Convolutional Neural Network(CNN)というタイプのモデルを開発した(下のグラフィックス)。

この研究はトロント大学でGeoffrey Hinton教授の元で行われ、これがAIブームの口火を切った。

HaungとSutskeverの対談

GTC 2023では、HuangがSutskeverと対談し、ChatGPTとGPT-4に関する開発手法、課題、次の開発計画などが明らかになった。

Sutskeverは「開発の難しさは信頼できるAIを作り上げること」と述べ、開発にかかる舞台裏の苦労を説明した。

信頼できるAIとは、人間の指示を正しく理解し、指定された範囲を逸脱しないで、安全に回答する機能を指す。

また、開発計画として、マルチメディアを扱うモデルを開発していることを明らかにした。

今のモデルはテキストを処理するが、次のモデルではこれに加えイメージやボイスを扱うことができる。

ChatGPTの構造

OpenAIは、GPT、GPT-2、GPT-3を開発してきたが、ChatGPTはその後継モデルになる。

公開と同時にChatGPTは大ヒットとなり、利用者数は1億人を突破した。

Huangは、ChatGPTがブレークした理由はユーザインターフェイスで、使いやすい構造で、誰もが高度なAIを使うことができるようになったと分析する。

ChatGPTのインターフェイスは対話モデルで、人間と対話する要領で、ChatGPTを使うことができる。

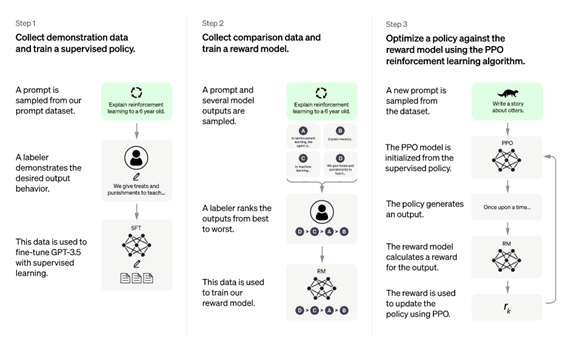

このインターフェイスは「Reinforcement Learning from Human Feedback (RLHF)」という手法で開発された(下のグラフィックス)。

ChatGPTの回答を人間が評価し、それを強化学習のモデルにフィードバックし、ChatGPTが回答の仕方を学習する。(グラフィックス:指示に従って回答を出力するスキルを獲得するプロセス。人間が手本を示し、これをChatGPTの強化学習モデルが学び、解答するスキルを向上させる。)

ChatGPTとGPT-4の違い

ChatGPTは言語モデル「GPT-3.5」をベースとするチャットボットで、GPT-4はその後継モデルとなる。

ChatGPTは人間と会話するためのチャットボットであるが、GPT-4はこの機能を含め広範な機能を持つ。

また、ChatGPTはテキストを扱うモデルであるが、GPT-4はテキストの他に、イメージやオーディオなど、マルチメディアを扱うことができる。

GPT-4は視覚を得た

GPT-4がイメージを扱うことで、コンテクストを理解する機能が格段に向上した。

AIが視覚を獲得したことを意味し、「赤色と青色の違いを、実物を見て理解できる」ようになった。

今までは、言葉で色の違いを把握していたが、GPT-4は人間のように目で見て違いを理解する。

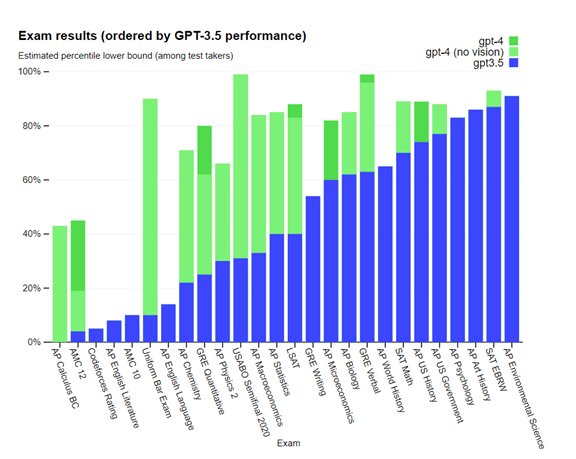

GPT-4のベンチマーク

実際に、この機能は試験問題を回答する技量で発揮された。

GPT-4は高校生向けの数学の試験「AMC 12」を受け、上位50%の成績を収めた(下のグラフ、左から二番目)。

ChatGPTから大きく性能が向上したが、これは「Vision(視覚)」を試験問題で使ったことによる。

数学の試験では図表が使われ、ChatGPTはこれを理解することができなかったが、GPT-4は視覚を得て、人間のようにテキストと図表を理解して数学の問題を解いた。

これにより成績が格段に向上した。(下グラフは試験問題に対する成績を示している。青色がGPT-3.5(ChatGPT)で、緑色がGPT-4。緑色でも濃い部分はビジョンを使って問題を解いた時の成績。)

AI開発の難しさ

SutskeverはHuangからAI開発の難しさを尋ねられ、それは「新しい機能を開発することより、信頼できるAIを開発すること」が最も難しいと回答した。

信頼できるAIとは、人間の指示に的確に回答することと、指定された範囲で安全な回答を生成することにある。

AIは差別発言をしたり、社会に害悪を及ぼす回答を出力する。更に、AIが夢想状態になり、とてつもないストーリーを生み出す。

OpenAIはガードレール(下の写真、イメージ)と言われる安全装置をアルゴリズムに組み込み、信頼できるAIを開発している。

しかし、安全装置は完全ではなく、AIの暴走を抑えることができない。安全なモデルを開発することがグランドチャレンジとなる。

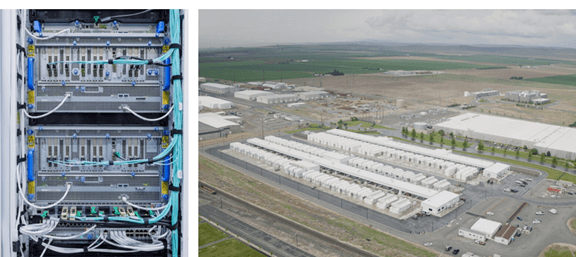

Microsoftのデータセンター

OpenAIはMicrosoftと提携し、大型言語モデルをMicrosoft Azureで開発している。

AzureはAI開発のためにNVIDIAのGPUをベースとしたスパコンを開発し、ChatGPTなどはこのプロセッサで開発された。

AzureはGPUの最新モデル「A100」や「H100 Tensor Core」を搭載し(下の写真左側)、OpenAIの大規模言語モデルの開発を支えている。(下の写真右側、Microsoftのデータセンター)。

AlexNetからGPT-4までNVIDIAが開発を支える

Sutskeverはトロント大学でAlexNetを開発する際に、NVIDIAの「GeForce GTX 580 GPU」を使用した。

当時、GPUは画像を処理するプロセッサでゲームエンジンなどで使われた。

これをAIで利用するという発想は無く、この研究がGPUという並列プロセッサがニューラルネットワークの処理に最適であることを実証した最初の研究成果となった。

それから10年にわたりNVIDIAのGPUがAI研究開発で使われ、ChatGPTなど言語モデルでブレークスルーを生み出した。