[No.9] 個人のプライバシーを侵害するAIへ”リベンジ”、顔認識アルゴリズムを攻撃し身を守る技術

我々の顔写真が本人の知らないうちに顔認識システムで使われている。

自撮りした写真をFacebookやInstagramに掲載するが、AI企業はこれをダウンロードし、顔認識アルゴリズムを教育する。

開発された顔認識AIは警察の犯罪捜査で使われている。

大学研究室で個人のプライバシーを守る技法が開発された。

シカゴ大学の研究成果

シカゴ大学(University of Chicago)のSAND Lab (Security, Algorithms, Networking and Data Lab)は、顔認識システムから個人のプライバシーを守る技術を開発した。

この技法は「Fawkes」と呼ばれ、顔認識システムのアルゴリズムを誤作動させ、ストーカーなどから身元を特定されるのを防ぐ方式を考案した。

この技法を使うと、顔認識システムが顔写真を読み込んでも正しく判定できなくなる。

顔認識システムとソーシャルメディア

いま米国で顔認識アルゴリズムを教育するために消費者の顔写真が無断で利用されていることが問題となっている。

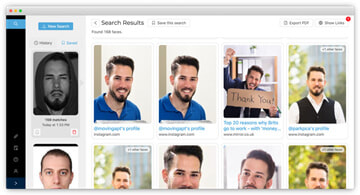

ニューヨークの新興企業Clearviewは高精度な顔認識AIを開発し、全米の警察が犯罪捜査で利用している(下の写真)。

Clearviewはソーシャルメディアに公開されている顔写真をダウンロードしてこのシステムを開発した。

ダウンロードした写真の数は30億枚を超え、世界最大規模の顔写真データセットを作り上げた。

プライバシー問題

ここには日本人の顔写真が含まれていることは間違いなく、本人の了解なくアルゴリズム教育で使われている。

市民団体は、個人の顔写真を無断で使用することは違法であるとして、Clearviewに対し集団訴訟を起こした。

一方、Clearviewは公開された顔写真を使う権利は憲法で保障されているとのポジションを取り、両者の意見が正面から対立している。

顔認識システムからプライバシーを守る

このためSAND Labは自制手段として顔認識システムからプライバシーを守る技法Fawkesを開発した。

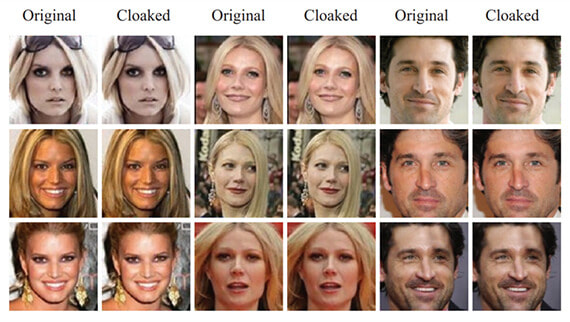

Fawkesは顔写真を加工する技術で、オリジナルの写真(先頭の写真、Originalの部分)に肉眼では分からない変更を加え、AIが顔を正しく判定できない改造写真(先頭の写真、Cloakedの部分)を生成する。

AI企業が改造写真を使って顔認識アルゴリズムを教育すると、完成したAIは正常に機能しなくなる。

Fawkesの使い方:SNSには改造した写真を掲載

Fawkesで加工した顔写真をFacebookやInstagramなどに掲載しておくと、個人のプライバシーを守ることができる。

AI企業はソーシャルメディアに掲載された顔写真をスクレイピングし、アルゴリズムの教育で使用する。

しかし、Fawkesで加工した改造写真でアルゴリズムを教育すると、写真には”毒”が盛られていて、完成したアルゴリズムは本人を正しく判定できない。一方、肉眼ではその違いは分からず、他の利用者は写真から本人を認識できる。

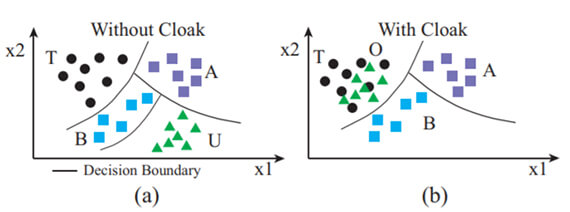

(下の写真左側:改造されていない写真でアルゴリズムを教育するとAIは正しく判定する。

右側:改造写真で教育されたアルゴリズムはUさんの写真をTさんと判定する)。

Fawkesの使い方:長期レンジの戦略

上述の通り、Clearviewは既にオリジナルの顔写真をスクレイピングしてアルゴリズムを開発しており、顔認識システムは正常に動作する。

しかし、Clearviewは定常的にソーシャルメディアに掲載されている顔写真をスクレイピングし、アルゴリズムをアップデートしている。

このため、ソーシャルメディアに改造した写真を掲載しておくことで、改版されたアルゴリズムが機能しなくなる。更に、多くのAI企業がネットに掲載されている顔写真を使ってアルゴリズムを教育しており、新規に開発される顔認識システムに対する防衛手段となる。

Fawkesの機能概要

Fawkesはオリジナルの顔写真に特殊な加工を施し、顔認識システムを誤作動する技法である(下のグラフィックス、左側)。

Fawkesはオリジナルの顔写真の特徴量を抽出し(Feature Extractor)、それを別人(Target T)のものに置き換える。ただし、写真の変更は最小限にとどめ、肉眼ではその変更を検知できない。

AI企業が改造さた写真を使って顔認識アルゴリズムを教育すると、完成したシステムはオリジナルの顔写真から本人を特定できなくなる(下のグラフィックス、右側)。

その他の防衛手段

個人のプライバシーを守るため、顔認識システムを誤作動させる研究が進んでいる。

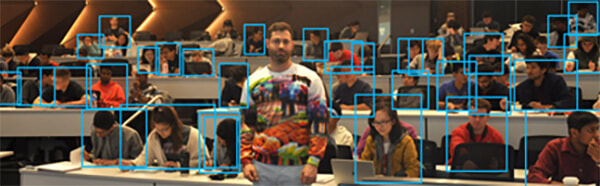

メリーランド大学(University of Maryland)のコンピュータサイエンス学部はオブジェクト認識システムに検知されない特殊なパターンを開発した。

このパターンをプリントしたプルオーバーを着ると、人物を検知するシステムに検知されない。

これを着て街を歩くと、セキュリティカメラの顔認識システムをかいくぐることができる。

この他に、顔に特殊なメーキャップをすると顔認識システムが顔として認識できなくなる。

(下の写真:特殊なパターンをプリントしたプルオーバーを着た人物はオブジェクト検知技術「YOLOv2」に検知されない。YOLOv2はリアルタイムのオブジェクト認識システムで、カメラに映った人物を特定しボックスで囲う。)

Fawkesの特徴

特殊なプリントは顔認識システムの検知から逃れプライバシーを自衛するために使われる。

一方、Fawkesはコンセプトが根本的に異なり、顔認識システムのアルゴリズムを攻撃し、その機能を停止させる技法である。

AIシステムへの攻撃で、運用者が気付かないうちにアルゴリズムが機能不全に陥る。

プライバシーを守るという目的は同じであるが、Fawkesはより高度な技法となる。

AIは攻撃を受けやすい

同時にFawkesは、AIは外部からの攻撃に対し脆弱であることを示している。

改造データでAIが攻撃を受けると、アルゴリズムの判定精度が下がり、また、機能不全に陥ることが明らかになった。

AIは常にサイバー攻撃の対象となり、攻撃を受けたことを把握しにくいという特徴がある。

AI開発者は個人のプライバシーを守ることに加え、ハッカーからの攻撃に対処する方策を講じる必要がある。