[No.71]テキストをイメージに変換するAIが公開される、誰でもAIアートを生成できる時代が到来

新興企業Stability AIは、言葉の指示に従ってイメージを生成するAI「Stable Diffusion」を開発した。

描きたい内容をテキストで入力すると、Stable Diffusionはそれに沿った画像を生成する。Stability AIはこのAIをオープンソースとして公開し、企業や個人はこのシステムを利用し、AIアートを生成できるようになった。

多彩なAIアートが生成されると期待されるが、同時に、ヌードイメージなど危険なコンテンツが大量生産されると懸念されている。

Stable Diffusionとは

Stable Diffusionはイメージを生成するAIモデルで、テキストの指示に従ってイメージを出力する。

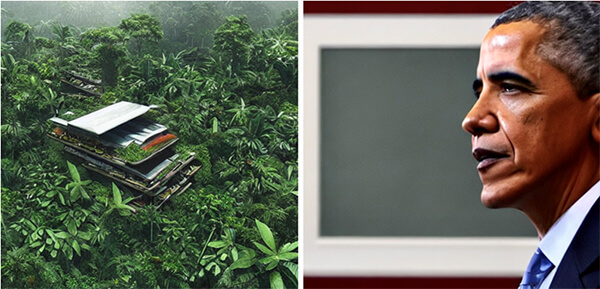

例えば、「人類が温暖化問題を解決した後に訪れる未来都市」と指示すると、Stable Diffusionはその命令に従った画像を生成する(上の写真左側)。

また、Stable Diffusionはオバマ前大統領の横顔を写真撮影したように生成する(右側)。

イメージを生成するAIはOpenAIが開発した「DALL·E」が有名であるが、Stable Diffusionはこれを追随し高品質な画像を生成する。

使ってみると

実際にStable Diffusionを使ってみると、AIはテキストに従って高品質なイメージを生成する。

「雪化粧したゴールデンゲートブリッジ」と指示すると、AIは写真撮影したような画像を生み出す。「ゴッホのスタイルで描いたゴールデンゲートブリッジ」と指示すると、油絵のタッチでイメージを生成する。

生成されるイメージは高品質でビジネスで活用できるレベルに達している。

AIの開発と教育

この技術はStability AIが、ルートヴィヒ・マクシミリアン大学ミュンヘン(Ludwig Maximilian University of Munich)などの研究機関と共同で開発した。

Stable Diffusionは同大学が開発したモデル(Latent Diffusion Models)をベースに開発された。Stable Diffusionはイメージ・データセット「LAION」を使って教育された。

このデータセットにはインターネットからダウンロードしたイメージとその説明が格納されている(下の写真、猫の事例)。Stable Diffusionは、イメージとその意味を学習し、指示された言葉に従って画像を生成する。

イメージ生成手法

Diffusionとは、教育されたアルゴリズムが指示に従ってイメージを生成する手法を指す。

Diffusionとは「拡散」を意味し、イメージをノイズに拡散するプロセスとなる。イメージを生成する際はこの逆のプロセスを辿り、ノイズからイメージを生成する手法となる。

これは「Denoising Process」と呼ばれ、ノイズを取り去る処理を繰り返し実施し、完全にノイズを除去して高精度なイメージを生成する(下の写真)。

オープンソース

Stable Diffusionはオープンソースとしてソフトウェアが公開されており、企業や個人はライセンスに従ってこれを無償で利用できる。

オープンソースのライセンスは様々な方式があるが、Stable Diffusionは「Open RAIL M license」という方式を取る。

このライセンスは、AIを研究開発で利用できるだけでなく、企業はモデルを改良し、それを製品として販売することができる。

利用制限を緩和

Stable Diffusionの特徴は、AIの危険性を認識するものの、その使用制限を大幅に緩和していることにある。

OpenAIなどは著名人を生成することを禁止しているが、Stable Diffusionにはこの制限はなく、オバマ前大統領を描くことができる(先頭の写真右側)。

情報操作に悪用

Stable Diffusionはオープンソースとして公開され自由に利用できるため、悪意ある団体が危険なコンテンツを生成する可能性が高まる。

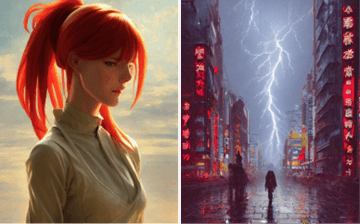

例えば、「中国が開発している火星着陸モジュール」と指示すると、AIはもっともらしいイメージを生成する(下の写真左側)。

「ロシア軍がキエフを支配下に収めた」と指示すると、ロシア軍が国旗を持って侵攻しているイメージが生成され(右側)、これらが情報操作で悪用される危険性をはらんでいる。

巨大テックの囲い込み

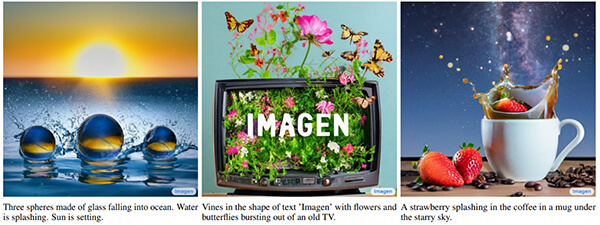

テキストからイメージを生成するAIは数多く開発されているが、それらはクローズドソースで、一般企業は利用することはできない。Googleの「Imagen」(下の写真)は社内に閉じて使われ、外部からシステムにアクセスすることはできない。

また、OpenAIの「DALL·E」は有償でAPIを公開しているが、ソースコードにはアクセスできない。巨大テックはAIをクローズドソースとして囲い込み、社内に閉じて開発している。

AI開発の民主化

Stability AIがStable Diffusionをオープンソースとして公開した理由は、大学やコミュニティと共同でAIを開発することで、技術が大きく進展すると期待するからである。

また、Stable Diffusionの制限を緩和し、AIの危険性が顕著になるが、ここでもコミュニティで安全な方式が生み出されると期待している。

巨大テックはクローズドソースでAI技術を囲い込んでいるが、Stability AIはこれを公開しAI開発を民主的に進めている。