[No.69]NVIDIAはリアルなデジタルヒューマンを生成するクラウドを公開、メタバースでアバターが人間に代わりアシスタントとして活躍する

NVIDIAは、コンピュータグラフィックス学会「SIGGRAPH 2022」で、メタバースに関連する技術を発表した。

公開された技術は、アバター技術、メタバース開発技術、AIグラフィック技術で、これらが3D仮想社会を生み出すプラットフォームとなる。

SIGGRAPHはメタバースとの関連が深く、ここで3DグラフィックスやAIグラフィックスの最新技術が発表された。

アバターを開発するクラウド

NVIDIAはメタバース関連技術の中で、アバターの開発を重点的に進め、最新モデル「Avatar Cloud Engine (ACE)」を発表した。

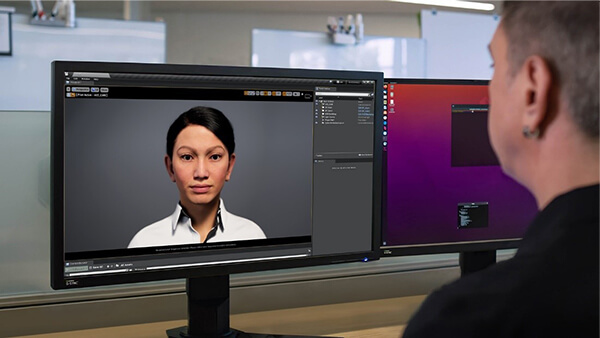

ACEとはクラウドベースのAIモデルで、実物と見分けのつかない高精度なアバターやデジタルヒューマンを開発するための基盤となる。企業はACEを使い、リアルなアバターを生成し、メタバースにおいて人間に代わるアシスタントとして利用する。

アバターはゲームや映画の中のキャラクターとして使われるだけでなく、銀行のテラーやホテルのレセプショニストとして活躍する。

アバターの機能

アバターは外観が人間そっくりであることに加え、高度な言語能力を備え、言葉でインタラクティブに応対する(上の写真)。人間が話しかけると、アバターはそれに返答し、両者間で会話が進む。アバターが話すときは、口がそれに同期して動き、顔の表情が変わる。

また、英語だけでなく、日本語やフランス語(下の写真)など、多言語で会話できる。

更に、アバターは会話のシチュエーションを理解し、それに応じた受け答えをする。

アバターを生成する仕組み

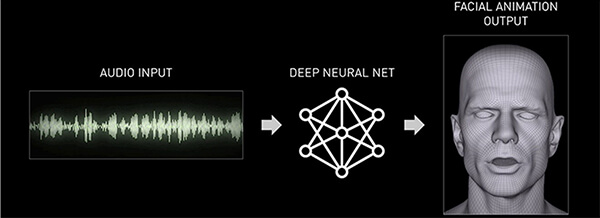

NVIDIAはアバター生成の基礎技術として「Audio2Face」を開発した。

これはオーディオを入力すると、ニューラルネットワークが3Dのアニメーションを生成する仕組みとなる(下のグラフィックス)。入力された言葉に従って、それを喋る3Dアバターが生成される。

アバターはリアルタイムで生成されるため、人間と対話するモデルで使うことができる。

感情の表現

SIGGRAPHではその最新モデルとして、感情を表現できるアバターが公開された。

これは「Audio2Emotion」と呼ばれ、入力されるオーディオの感情を読み取り、ニューラルネットワークはそれに合わせたアバターを生成する。

例えば、入力オーディオが「自分がどこにいるのか分からない!」という怒りを込めた言葉であると、AIは怒っている表情のアバターを生成する(下の写真、ビデオへのリンク)。

アバターの利用方法

生成されるアバターは3D仮想社会で人間に代わり様々なタスクをこなす。

NVIDIAはそのリファレンスモデルとして「Toy Jensen」を公開した。これはCEOであるJensen Huangをモデルにしたフィギュアで、難しい質問に回答する大学の先生として機能する(下の写真)。

また、アバターはレストランのモニターで、顧客と対話しながらメニューを紹介する。

更に、アバターは自動運転車に搭載され、コンシェルジュとして、ドライバーと対話しながら道案内をする。

AIで構成されるアバター

ACEで生成されるアバターは、高精度な3Dレンダリングに加え、人間と自然な会話ができるよう、多彩なAIが組み込まれている。人間が話す言葉を理解し、アバターはそれに対する返答をリアルタイムで生成し、会話を続ける。

また、AIはアバターの顔の表情や手の動きなど、アニメーションを生成する。

具体的には、ACEが提供するAI機能は次の通り:

- Riva:会話のためのAI

- Metropolis:ビデオ解析のAI

- Merlin:推奨エンジン

- NeMo Megatron:大規模言語モデル

- Omniverse:メタバースの開発環境

メタバース開発でリード

多くの企業がメタバースを開発しているが、高精度な3D仮想社会を生成する技法が、ビジネス成功のカギとなる。

NVIDIAはこの開発環境を「Omniverse」として提供しており、メタバース開発で業界標準のツールとして認識されている。

メタバースでは、利用者のデジタルツインであるアバターを介して交流が進み、如何に精巧なモデルを生成できるか、各社が競い合って技術開発を進めている。

NVIDIAはアバター開発でも業界をリードしており、人間と見分けのつかない、精巧で知的なデジタルツインを生み出している。