[No.4] 欧州と米国でAI規制が始まる、EUは規制案を公開、企業にAIの品質保証を求め違反すると制裁金が課される

欧州連合(European Union)は、AIの運用を規定したプロポーザルを発表した。

AIは社会に多大な恩恵をもたらすが、その危険性も重大で、EUは世界に先駆けてAIの運用規制に踏み出す。

警察は顔認識技術を使って市民を監視することが禁止される。

また、銀行はAIによる与信審査を導入する際は厳格な運用条件が課される。

一方、米国は連邦取引委員会(Federal Trade Commission)がAIの利用規制に関する意見書を公開した。

欧州と米国はAIの運用を厳しく制限する方向に進み、各国の企業は対応を迫られることになる。

EUのプロポーザル

欧州委員会(European Commission)は2021年4月21日、AI運用に関するプロポーザル「Proposal for a Regulation on a European approach for Artificial Intelligence」を公表した。

AIが社会に浸透し人々の生活にかかわる中、欧州委員会はAIの運用ルールを定め、危険なAIについては使うことを禁止する。プロポーザルはAI運用の指針を示したもので、EU加盟各国はこれをベースに法令を制定してAIの運用を規制する。

AI利用規定の内容

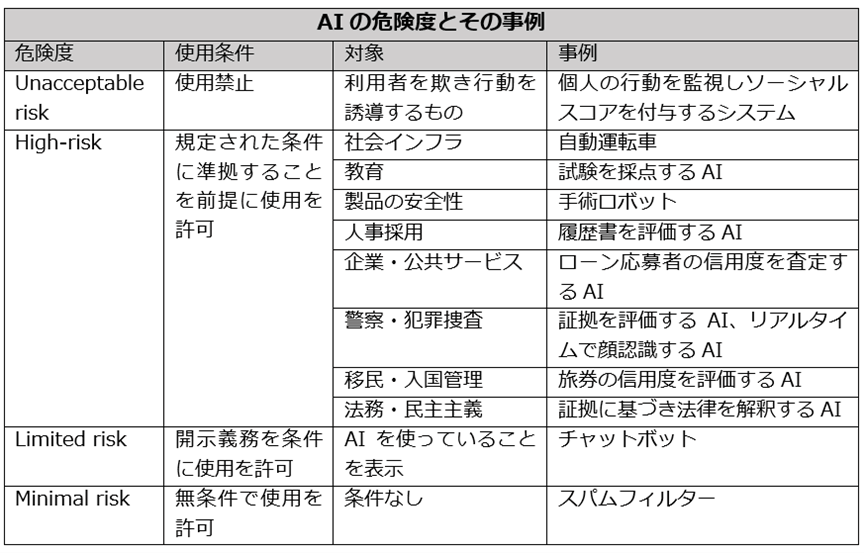

欧州委員会はAIの危険度を四段階に分けて定義し、それぞれの利用法を規定している。

危険 (Unacceptable risk)なAIはその使用を禁止する。

ハイリスク(High-risk)なAIについては、規定された対策を適用することを条件に使用が認められる。

ローリスク(Limited risk)なAIは、表示義務を条件に使用が認められる。

その他(Minimal risk)のAIは無条件で利用できる。また、これらの規定に従わないときは罰則規定が設けられ、制裁金(最大3000万ユーロか売上高の6%)が課される。

欧州委員会のプロポーザルの特徴は、ハイリスクなAIを定義し、その運用条件を定めたことにある。

AIの危険度とその事例

危険なAIとは監視カメラで市民の行動をモニターし、その挙動を解析し信用度を付加するAIとしている。

これは中国で実際に運用されているが、欧州委員会はこれを全面的に禁止する。

ハイリスクなAIは、人間に代わり試験を採点するAIや、人事採用で履歴書を評価するAIなどが含まれる。

また、銀行でローン審査を担うAIや、裁判所で証拠を検証し判決を下すAIが対象となる。

更に、警察の犯罪捜査で使われる顔認識AIが含まれる。欧州委員会が示したAIの危険度とその事例は下記のテーブルの通り:

ハイリスクなAIを利用する条件

ハイリスクなAIを使う際はその運用に厳しい条件が課される。

AIのアルゴリズムが偏ってなく、人種や性別や年齢にかかわらず公正な判定を下すことが求められる。

また、AIのアルゴリズムのメカニズムを詳細に説明したドキュメントの制作が求められる。

消費者がAIの機能や品質や使用方法を理解し、正しく利用できる説明書を求めている。

ハイリスクなAIを運用する条件は下記の通り:

- リスクの査定とリスク回避:AIの危険性の評価とリスクを回避するシステムを導入

- 高品質なデータセット:アルゴリズム教育向けデータの品質を向上しリスクを低減

- AI運用のログ:AI評価結果のトレーサビリティ

- AIに関するドキュメント:AIの機能説明とコンプライアンス評価

- AI使用説明書:利用者向けのAI使用手引き

- 人間によるAIの監視:AIのリスクを最小限にするため人間が監視

- AIの安定性:AIが外部の攻撃に耐性があり、高精度な判定機能を持つこと

ローリスクなAI

ローリスクなAIは対話型のチャットボットで、人間ではなくAIが応答していることを明示することを義務付ける。

その他のAIは無条件で利用でき、スパムフィルターなどがこれに該当し、特別な条件なしでAIを運用できる。

次のステップ

欧州委員会がプロポーザルを作成した背景には、EUはヒューマンセントリックスなAIを開発し、AI技術で世界をリードするとの狙いがある。

これらは欧州委員会の提案書であり、加盟各国はこれをベースに独自の法令を制定するプロセスとなる。

2018年にEU一般データ保護規則(General Data Protection Regulation; GDPR)が導入され、加盟各国はこれをベースに独自の法令を定めたように、AIも同じプロセスをたどることになる。

米国におけるAI規制の状況

米国は連邦政府レベルでAIの利用を規制する法令は無く、州や市が独自の法令を定め運用している。

特に、顔認識技術の危険性が指摘され、警察がこれを犯罪捜査で使用することを禁止する法令が制定されている。

サンフランシスコやボストンなどは、警察が顔認識技術を使うことを禁止する法令を制定した。一方、殆どの自治体はこれを禁止する法令は無く、顔認識技術が幅広く使われている。

米国はFTCが見解を発表

米国においても連邦政府レベルでAIの運用を規制するルールの制定が始まる。

FTCは消費者を不公正な商取引から保護することをミッションとするが、AI運用に関するコメントを発表し、企業にAIを公正に活用することを促した。

FTCは既に、AIとアルゴリズム利用に関するガイドラインを発表しているが、今回のコメントはそれを一歩進め、AIの不公正な利用を法令で取り締まることを示唆した内容となった。

AIを管轄する法令

これによると、FTCは不正な商取引を禁止しており(FTC Act)、人種差別につながるアルゴリズムの販売は禁止される。

また、人事面接でアルゴリズムが応募者を不採用にする行為は消費者を公正に格付けする法令(Fair Credit Reporting Act)に抵触する。

更に、アルゴリズムが不正に特定の人種や性別や国籍によりローンを認めないケースでは、公平な権利を規定した法令(Equal Credit Opportunity Act.)に抵触する。

FTCはAI規制を強化する

GDPRが示すように、EUはハイテク企業に対し、プライバシー保護や個人の権利に関し厳格な対応を求める。

一方、FTCは米国企業が中心のハイテク企業に対しては、ビジネスを優先し寛大なポジションを取ってきた。

しかし、AIに関してはこの流れが変わり、FTCもハイテク企業に対し、EUと同じレベルの規制を導入するとの見方が広がっている。

AI企業は対応を求められる

米国で危険なAIがルール無しに運用され社会に混乱が広がっている。

高度な顔認識技術を提供するClearviewは、Facebookから顔写真をスクレイピングし消費者の間で懸念が広がっている。

FTCがAI運用に関する統一したルールを制定することで、消費者の権利が守られ、安心してAIを利用できると期待される。

一方、AI企業は制定される法令に沿った品質保証が求められ、AI開発は大きな局面を迎える。