[No.181]ヒントン教授はAI基礎技術「ボルツマンマシン」の開発でノーベル物理学賞を受賞、人工ニューラルネットワークがデータに内在する特性を把握、モデルが学習する機能を実現しAIブームに繋がる

今年のノーベル物理学賞はAIの基礎技術「人工ニューラルネットワーク」の開発に関わった、ジョン・ホップフィールド教授とジェフリー・ヒントン教授に授与された。

ホップフィールド教授は連想記憶技術を開発し、ヒントン教授はこれを基盤とし、モデルが学習するメカニズムを考案した。その後、ヒントン教授はイメージを識別するモデルを開発し、これが今のAIブームの起点となった。

ヒントン教授はGoogleでAI研究を続けてきたが、昨年退社し、今は自由な立場でAIの危険性について警鐘を発信している。

受賞会見ではAIが人類を滅亡させるリスクに触れ、AI規制法の整備とAIの安全性に関する研究を強化することを提唱した。

ノーベル物理学賞

スウェーデン王立科学アカデミー(Royal Swedish Academy of Sciences)は、機械学習の基礎技術となる人工ニューラルネットワーク(Artificial Neural Network)の考案に関わったジョン・ホップフィールド教授(John Hopfield)とジェフリー・ヒントン教授(Geoffrey Hinton)にノーベル物理学賞を授与した:

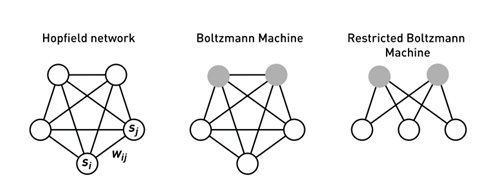

- ヒントン教授:ホップフィールド・ネットワークを拡張して「ボルツマンマシン(Boltzmann Machine)」を考案(中央)。人工ニューラルネットワークがデータに内在する特性を把握する技法。その後、「リストリクティッドボルツマンマシン(Restricted Boltzmann Machine、RBM)」の研究に関与し軽量で効率的なモデルを開発(右側)。

- ホップフィールド教授:人工ニューラルネットワークで連想記憶(associative memory)のモデルを開発。このモデルは「ホップフィールド・ネットワーク(Hopfield Network)」と呼ばれ(下の写真左側)、情報を格納しそれを読み出す技術。

ボルツマンマシンとは

ヒントン教授は1985年、他の研究者と共同で新しい構造の人工ニューラルネットワーク「ボルツマンマシン」に関する論文を発表した。

ボルツマンマシンは「回帰型ニューラルネットワーク(Recurrent Neural Network)」というタイプのモデルで、システム内で処理が循環する構造となる。回帰処理(繰り返し処理)によりノード間の重み(Weights)が更新され、最適なポイントに到達する。

ボルツマンマシンのコンセプトはモデルのエネルギーを最小にすることが目的で、統計力学の手法「ボルツマン分布(Boltzmann Distribution)」を導入した。

これがモデルの名称となっている。

ボルツマンマシンのネットワーク構造

ボルツマンマシンは人工ニューラルネットワークで、ニューロン(ノード、上の写真の○)が結合された構成となる。

結合の強さは重み(Weight、上の写真Wij)で決定され、ノードがオン・オフの状態を取る。また、ノードは「Visible Nodes」(白丸)と「Hidden Nodes」(黒丸)で構成される。

前者は外部とつながり、データを読み込み、また、データを読み出すことができる。

後者は外部との接続は無く、ネットワーク内で処理を実行し、様々な特性を学習する。

リストリクティッドボルツマンマシン(RBM)とは

ボルツマンマシンは入力データの含まれている特性を把握する機能を持つが、その構造は回帰型ニューラルネットワークで、ノードごとに逐次処理をするため、演算に時間がかかる。

RBMはボルツマンマシンを軽量化した構造で、効率的に処理ができるモデルとなる。RBMは各層におけるノード間の接続は無い軽量な構造で、層ごとに処理を実行し計算量を減らし、効率的なモデルとなる。

RBMも同様に、モデルのエネルギーを最小にするポイントを算出することがゴールとなる。その際に、ヒントン教授は効率的なアルゴリズム「Contrastive Divergence」を考案し、モデルが収束するスピードを高速化した。

RBMの使い方

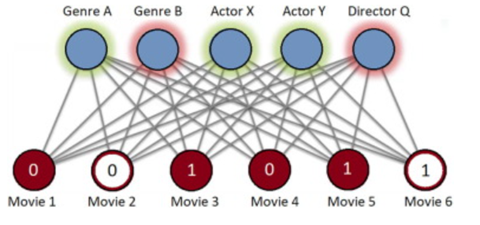

RBMは入力データに含まれている特性を抽出するために使われる。

RBMはEコマースサイトで商品やサービスを推奨するシステムのコア技術として利用されてきた。例えば、映画推奨システムでは、消費者が見た映画をRBMに入力すると、その消費者が興味を示す映画を提示する(下の写真)。

モデルの下段がVisible Nodesで、ここに映画のタイトルなどを入力し、上段がHidden Nodesで、入力されたデータに内在する特性を把握する。具体的には、消費者の映画に関する嗜好(ジャンルや俳優の好み)を把握する。

これをベースに推奨する映画を出力する(Visible Nodesの白丸の部分)。

フィードフォワードネットワーク

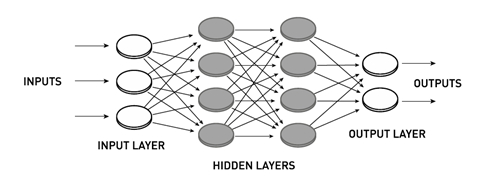

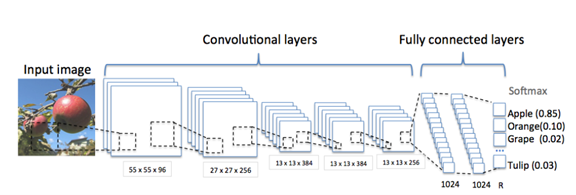

回帰型ニューラルネットワークの研究と並列して、フィードフォワードネットワーク(Feedforward Networks、下の写真)の研究が進行した。

これは、ネットワーク処理のフローが前進するタイプで、「Input Layer」が入力データを受け取り、これを「Hidden Layers」で処理し、その結果を「Output Layer」が出力する形式となる。現在のニューラルネットワークの多くがこの方式を取っている。

ヒントン教授は他の研究者と共同で、ネットワークを教育する手法「バックプロパゲーション(Backpropagation)」を考案し、これが深層学習(Deep Learning)の開発を加速させる革新技術となった。

バックプロパゲーションは、ニューラルネットワークの出力と正解を比較し、その誤差(Loss)を最小にする手法で、各層のノードのパラメータ(重みとバイアス)を最適化する。

畳み込みニューラルネットワーク

1980年代にはフィードフォワードネットワークである「畳み込みニューラルネットワーク(Convolutional Neural Networks(CNN))」が開発された。

Yann LeCunが「LeNet-5」というアーキテクチャを発表し、これが現在のCNNの基礎技術となった。2012年には、ヒントン教授のチームが「AlexNet」を発表しCNNの性能が大きく進化した。

AlexNetはイメージの中のオブジェクトの種類を特定する技術で、ニューラルネットワークが高い精度をマークした(下の写真、写真に写っているリンゴを判定したケース)。イメージ判定コンペティション「ImageNet Large Scale Visual Recognition Challenge」で、AlexNetにより判定精度が劇的に向上し、AI業界に衝撃をもたらした。

この研究はヒントン教授と門下のAlex KrizhevskyとIlya Sutskeverで行われた。Sutskeverはその後、OpenAIの設立に加わりAIの安全技術を研究していたが、現在は、スタートアップ企業を創設し、ここで研究を継続している。

DNNresearch

この研究成果を切っ掛けに、ヒントン教授らはAI研究の新興企業「DNNresearch」を設立した。

ここで、「Deep Neural Networks (DNNs)」と呼ばれる深層学習の分野で、ネットワークの階層を多段にしたモデルの研究を進めた。2013年、GoogleがDNNresearchを買収し、ヒントン教授らはGoogle配下で研究を続け、この成果がGoogle Photoなどで使われた。

AIの危険性に関する啓もう活動

2023年、ヒントン教授はGoogleを去り、自由な立場でAIの危険性を発信し、社会に向かって警鐘を鳴らしている。

ヒントン教授はノーベル賞の記者会見で、AIが社会に多大な利益をもたらすと同時に、重大なリスクを抱えていると述べた(下の写真)。短期的には、AIによりフェイクイメージが拡散し、選挙において有権者が誘導される危険性を指摘。長期的にはAIが人類を滅亡させるリスクについて見解を提示した。

人間よりインテリジェントなAIが開発されたとき、人類はこのスーパーインテリジェンスをどう制御するのか、重大な懸念を示した。このモデルはあと5年から20年のレンジで開発されるとの予測を示し、AI開発において安全技術の研究が極めて重要であると述べた。

企業は開発費用の30%をこの研究に費やし、安全なモデルの開発を進めるべきで、政府はAIを安全に運用するための規制法を整備する必要があるとの見解を示した。これからは第一線の研究から実を引き、AIの安全性に関する活動に専念するとしている。