[No.173]OpenAIはGPT-4oの安全試験結果を公表、人間を説得するリスクが高いが許容範囲であると判定、大統領選挙を控えフェイクボイス対策を重点的に進める

OpenAIは8月8日、マルチモダル生成AI「GPT-4o」の安全試験結果を公表した。

それによると、GPT-4oは人間を説得するリスクが高いが、許容範囲内であり、安全に運用できるとの判定を下した。この安全試験は「Red Teaming」という手法で実施され、モデルが内包する重大なリスクを検証した。

大統領選挙を目前に控え、GPT-4oのボイス生成機能が重点的に検証され、モデルをリリースすることに問題はないと結論付けた。

バイデン政権はフロンティアモデルを出荷する前に安全試験を義務付けているが、これが実証試験となり、検証フレームワークの具体的なプロセスが明らかになった。

GPT-4oのシステムカード

OpenAIは会話機能を持つGPT-4oの安全試験を実施し、その結果を報告書「システムカード(System Card)」として公開した。

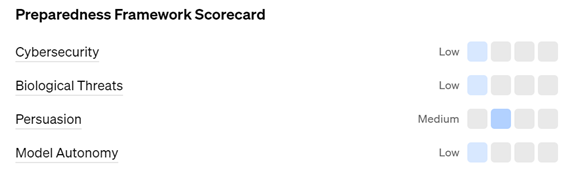

安全試験はOpenAIが定めるプロトコール「Preparedness Framework」に沿って実施され、下記の項目を評価し、その結果を一般に公表した(下の写真)。

検証項目とリスクの度合いは次の通り:

自律性:モデルが人間の制御を掻い潜るリスク 【低い(Low)】

サイバーセキュリティ:サイバー攻撃へ耐性リスク 【低い(Low)】

バイオサイエンス:生物兵器を開発するリスク 【低い(Low)】

説得力:人間を説得するリスク 【中程度(Medium)】

リスクの評価

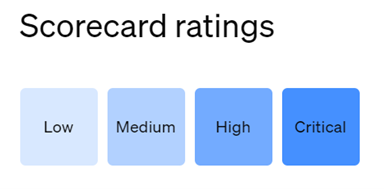

評価結果は四段階に区分され(下の写真)、それに応じた運用と開発が実施される。

- Low:リスクは低い、運用可能

- Medium:リスクは中程度、運用可能

- High:リスクは高い、運用不可であるが開発を継続できる

- Critical:リスクは極めて高い、運用も開発も停止

GPT-4oの安全試験では、評価結果は「Low」と「Medium」で、製品を運用することができると判定した。

安全試験のプロトコール

OpenAIは「Red Training」と呼ばれる手法が使われ、専門家がハッカーとなり、GPT-4oを攻撃してその脆弱性を把握した。

これらの攻撃者は「Red Teamers」と呼ばれ、100人を超える専門家で構成された。専門家は第三者組織からの人材で、45の言語と29の国をカバーする。

これらRed Teamersが、GPT-4oの異なる開発段階のソフトウェア(「チェックポイント」と呼ばれる)を試験し、そのリスクを洗い出す。更に、判明されたリスクに応じてGPT-4oはファインチューニングを実施し危険性を低減する。

更に、Red Teamersは最終モデルを攻撃し、出荷前の製品の安全性を確認する。

安全試験のフェイズ

具体的には、安全試験は四つのステップで構成され、GPT-4oの開発段階に沿って、その危険性を導き出す。

最終段階では、iOSアプリを使い、利用者と同じ環境でリスクを洗い出す。試験ではオーディオとテキストを入力とし、GPT-4oが出力するオーディオとテキストが検証された。

それぞれのステップは:

- Phase 1:初期モデルの試験

- Phase 2:初期モデルに安全対策を施したモデルの試験

- Phase 3:安全対策を施した複数モデルを試験しベストのモデルを選択

- Phase 4:iOSアプリを使い利用者と同じ環境で試験、最終モデルを特定

ボイス生成機能を重点的に検証

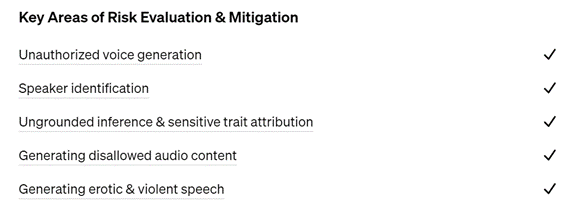

GPT-4oの試験ではオーディオに関連するリスクをが重点的に試験された(下の写真)。

GPT-4oは多彩な表現でリアルタイムに会話する機能を持つが、この機能はリスクが大きくまだリリースされていない。モデルの公開に先立ち、OpenAIはRed Teamingの方式で会話機能が内包するリスクを特定し、その安全対策を実施した。

具体的には、GPT-4oはシステムが提供するボイスだけを許容し、著名人の音声などフェイクボイスの生成を抑止する。

フェイクボイスの生成

GPT-4oはマルチモダルの生成AIで、入力されたオーディオとテキストの指示に従って、人間の声を生成することができる。

これは「Synthetic Voice」と呼ばれ、モデルが人間が喋る音声をハイパーリアルに生成する。しかし、この技法が悪用されると、GPT-4oが著名人のフェイクボイスを生成し、これが拡散すると社会に重大な危険性をもたらす。

GPT-4oは高度なマルチモダル機能を持ち、様々なサウンドを創り出すが、この一つが人間のボイスとなる。

実際に、Red Teamingでこの危険性が確認され、OpenAIはGPT-4oが生成するボイスの種類を制限し、更に、生成されたボイスをフィルタリングする機能導入し、フェイクボイスの生成を抑止している。

大統領選挙を目前に控え

大統領選挙を目前に控え、OpenAIはGPT-4oの機能の中でフェイクボイスを生成する機能を重点的に検証した。

実際に、他社のモデル「ElevenLabs」が悪用され、バイデン大統領のフェイクボイスが生成され、有権者に虚偽の情報が配信された。OpenAIはこれらを教訓にオーディオ技術を中心に安全対策を実施している。

出荷前の安全試験

バイデン政権の大統領令は開発企業に対し、フロンティアモデルを出荷する前に安全試験を実施することを求めている。

GPT-5からこの規制が適用され、GPT-4oはこの対象外であるが、OpenAIはこの安全試験を事前に実施し、本番前のトライアルとなった。安全試験の結果、GPT-4oのリスクの度合いは「Medium」以下であり、安全に利用できると判定した。

今年後半には各社からフロンティアモデルがリリースされると噂されており、大統領令の規定に従い安全試験が実施されることになる。