[No.138]人間の知能を遥かに上回るAIをどう制御するか、OpenAIは“スーパーアラインメント”の研究を開始し最初の成果を発表

人間の知能を遥かに上回るAIは「スーパーインテリジェンス(Superintelligence)」と呼ばれ、社会に多大な恩恵をもたらすとともに、人類存続の脅威になると考えられている。

OpenAIは、10年以内にスーパーインテリジェンスが開発されると予測しており、その安全性を研究する専任部門を設立し、制御技法の研究を進めている。

4年計画のプロジェクトで、その最初の成果を発表した。

スーパーインテリジェンスとは

スーパーインテリジェンスは一般に、「Artificial Superintelligence (ASI)」と呼ばれ、人間の知能を遥かに上回るAIと理解される。

厳密な定義は無いが、知的能力が高く、幅広い分野で難解な問題を解決すると期待されている。例えば、地球温暖化問題やがんなどの難病の治療法などで解法が期待されている。

一方、スーパーインテリジェンスは人間の制御を逃れ、人類の弱体化や滅亡に繋がると強く危惧されている。

スーパーアラインメント

スーパーインテリジェンスは映画で登場するAIで、技術概要や開発時期について統一した見解は無い。

しかし、OpenAIは、スーパーインテリジェンスは10年以内に開発されると予測しており、その安全性に関する研究を開始した。スーパーインテリジェンスを安全に制御する技法は「スーパーアラインメント(Superalignment)」と呼ばれ、AIを人間の価値観に沿うように改良する技法となる。

現行の生成AIを安全に運用する技術は「アラインメント(Alignment)」と呼ばれるが、これを拡張したコンセプトとなる。

どう制御するか

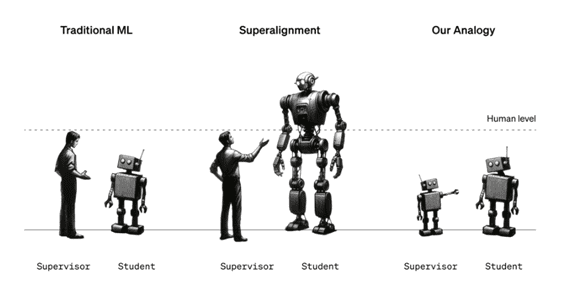

GPT-4など生成AIを改良し安全性を強化する際は、人間が教師となりAIを指導する(下のグラフィックス左側)。

教師である人間の知能はAIより高く、人間の常識などをアルゴリズムに教える。その代表手法が「Reinforcement Learning from Human Feedback」で、人間が正しい答えをモデルにフィードバックする。

しかし、人間の知能を遥かに上回るスーパーインテリジェンスが登場すると、このモデルの安全性を如何に担保するかが重大な課題となる(下のグラフィックス中央)。

超人的な知能を持つAIを人間が教育できるかが問われる。

OpenAIの手法

OpenAIは、スーパーアラインメントの専任研究組織で、このテーマに関する研究を進めている。

この組織は3月に設立され、今週その最初の研究成果を発表した。スーパーインテリジェンスは登場しておらず、実際のモデルを使って技法を開発することはできない。

このため、OpenAIはスーパーアラインメントの論理モデルを構築し、その成果を計測した。

小さなモデル(Weak Model)が教師となる、大きなモデル(Strong Model)の生徒を教育し、安全性を強化できるかが試験された。

試験の結果

この研究では小さなモデル(教師)として「GPT-2」(下のグラフ最上段)が、大きなモデル(生徒)として「GPT-4」(最下段)が使われた。

GPT-2は生成AIの初期のモデルで、その機能は限られている。GPT-4は最も高度な生成AIで、GPT-2がGPT-4を制御できるかが試験された。

GPT-2が生成するコンテンツでGPT-4の安全機能を再教育した。このアラインメントでGPT-4の安全性は向上するが、その性能は劣化する(下のグラフ、緑色)。

しかし、特別な技法(Auxiliary Confidence Loss)を導入することで、本来の性能に近づけることができる(下のグラフ、紫色、GPT-3.5程度の性能を示した)。

研究の意義

この研究では小さなモデル(GPT-2)が大きなモデル(GPT-4)を制御できる筋道が示された。

これは「Weak-to-strong generalization」と呼ばれ、人間(小さなモデル)がスーパーインテリジェンス(大きなモデル)を教育する際に、この方式が適用できるかが問われる。

スーパーアラインメントに関する研究の第一歩で、OpenAIはスーパーインテリジェンスが開発される間に、この課題を解く計画である。

スーパーアラインメント研究

スーパーインテリジェンスに関しては統一した定義はなく、その登場時期も様々な議論がある。

しかし、OpenAIはスーパーインテリジェンス開発で大きなブレークスルーがあった、という憶測がソーシャルメディアで交わされている。CEOのSam Altmanの解任はスーパーインテリジェンスに関連すると噂されている。

OpenAIは超人的なAI開発を進めており、スーパーアラインメントに関する研究が極めて重要な位置を占める。

この研究に会社のリソースの20%を充てると述べており、AI開発は安全開発でもある。