[No.117]バイデン政権はAIの安全性に関するガイドラインを制定、OpenAIの「GPT-4」やGoogleの「PaLM 2」はモデルの安全検査を求められる

今週、バイデン大統領はGoogleやOpenAIなどAI企業7社と会見し、AIの安全性に関するガイドラインを発表した(下の写真)。

これは「Voluntary Commitments」と呼ばれ、法的義務はない自主規制であるが、企業7社がこれに同意し、AIモデルの安全検査を実施する。

このガイドラインは、アメリカ国民をAIの危険性から守ることに加え、中国などを念頭に、国家安全保障を強化する構造となっている。米国政府はAI規制法の準備を進めているが、このガイドラインが法案の骨格を構成し、AI規制政策の構造を理解できる。

ガイドラインの概要

バイデン政権はAIの安全性に関するガイドラインを公表し、開発企業はこの規定に沿って、モデルの安全性を検証することとなる。

対象となるモデルは生成AIだけで、OpenAIの「GPT-4」と「DALL-E 2」、また、Googleの「PaLM 2」(Bardのエンジン)などに適用される。ガイドラインは「安全性」、「セキュリティ」、「信頼性」の三つの基軸から構成される。

- 安全性 (Safety):モデルの安全性を検査。開発企業はアルゴリズムを検査し、AIが兵器開発に悪用される可能性など、危険性を洗い出す。

- セキュリティ (Security):サイバー攻撃に備える。生成AIは国家安全保障にかかわる機密情報を含んでおり、サイバー攻撃に備え、情報管理を厳格にする。

- 信頼性 (Trust):信頼できるAIを開発。生成AIで制作したコンテンツには、その旨を明示し、利用者に信頼できる情報を提供する。

安全性 (Safety)

ガイドラインは安全性に関し、AIモデルを検証することと、AIモデルに関する情報を共有することを求めている。

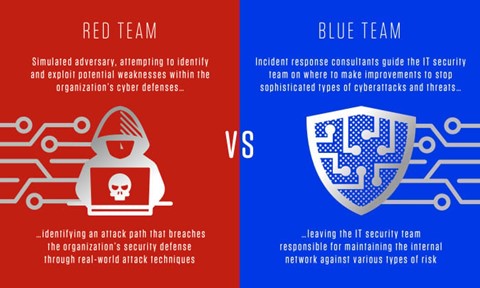

AIモデルの検証では「Red-Teaming」という手法を推奨しており、社内だけでなく社外組織と共同でこれを実行する。(Red-Teamingとは、開発者がハッカー「Red Team」となり、モデルに様々な攻撃を行い、もう一方の開発者「Blue Team」がこれを防衛する手法で、アルゴリズムの脆弱性を把握し、モデルの危険性を理解する。)

安全性 (Safety):モデルの危険性とは

この手法でモデルが内包する危険性を洗い出し、市民生活に及ぼすリスクの他に、サイバー攻撃などの国家安全保障に関する危険性も把握する。

ガイドラインが懸念する主なリスクは:

- 兵器製造:生物学兵器、化学兵器、核兵器開発にAIが悪用されるリスク

- ハッキング:システムの脆弱性を検知するためにAIが悪用されるリスク

- システム制御:AIがサイバー空間を超え物理装置の制御を奪うリスク

- 社会問題:AIのバイアスや差別により社会に悪影響を与えるリスク

安全性 (Safety):情報共有と標準規格

ガイドラインは、各社がモデルを検証してこれらのリスクを査定するが、その検証結果を企業や政府と共用することを求めている。

更に、リスクを査定する手法については、アメリカ国立標準技術研究所(NIST)が制定した「AI Risk Management Framework」に準拠することを推奨している。

これは責任あるAI開発と運用を規定したフレームワークで、米国におけるAI技術の標準仕様書となっている。

セキュリティ(Security)

ガイドラインは、AIモデルに関する情報は知的財産で、これが盗用されないようセキュリティを強化することを求めている。

外部からのサイバー攻撃と、内部関係者による盗用に備え、セーフガードを強化することを求めている。

AIモデルの知的財産とは、アルゴリズムのパラメータ「Weights」を指し、開発企業はこれを厳重に守ることを求めている。

(「Weights」とはアルゴリズムのパラメータの値を指す。「Weights」はアルゴリズムをデータで教育して決定する。生成AIは大規模なモデルで、Weightsを決定するには、スパコンを使って大規模な計算が必要となる。)

信頼性(Trust)

ガイドラインは、生成AIが出力したコンテンツには、その旨を明記することを求めている。

対象は、テキストの他に、オーディオやイメージで、利用者がその背景を正しく理解できることが重要としている。

更に、開発企業に、オーディオやイメージに関し、その出典やウォーターマークを挿入するメカニズムの導入を求めている。

また、開発企業に、AIモデルの機能だけでなく、制限事項や対象分野などをドキュメントとして公開することを求めている。これは「Model Card」といわれる手法で、AIモデルの取扱説明書となる。

信頼性(Trust):イノベーション

ガイドラインは、更に、高度なAIのイノベーションを進め、社会が抱えている問題の解決に寄与するよう求めている。

これらはグランドチャレンジと呼ばれ、地球温暖化の抑止やがんの早期検知やサイバー攻撃への防御技術などで、AIがこれらの解法に寄与すべきとしている。更に、開発企業は、学生や労働者へAIに関する教育や啓もう活動を通し、皆がAIの恩恵を享受できるよう求めている。

米国と欧州との違い

バイデン政権が制定したガイドラインは、生成AIに限定し、国民の安全を守ることに加え、国家安全保障を強化することを規定している。

特に、生成AIの知的財産を守り、敵対国やハッカー集団に悪用されることを防ぐことに重点を置いている。

これに対し、EUが最終調整を進めているAI規制法「AI Act」は、生成AIを含む広範なAIを対象に、利用者の権利を守ることを主眼に置いている。更に、AIモデルを教育するデータに関する規制もあり、著者者の権利を保護することを規定している。米国のガイドラインは国家安全保障の強化に重点を置いていることが特徴となる。

米国の法令整備

ガイドラインは、法的な拘束力はなく、合意した企業がこれに基づき、自主的に義務を履行する構造となる。

合意した企業は7社で、Amazon、Anthropic、Google、Inflection、Meta、Microsoft、及び OpenAIがガイドラインに従って安全性を検証する。

また、このガイドラインは、AI規制法が制定されるまでの規約で、暫定的な措置という位置づけとなる。

現在、米国政府はAI規制法の準備を進めているが、このガイドラインがその構成のベースとなる。AI規制法の制定までには時間を要すが、ガイドラインからAI規制法の姿を読み取ることができる。