ローカルAI時代のGPU選び完全ガイド2026【生成AIモデル別 推奨VRAM編】

本記事は、ローカルAI環境で生成AIを運用する企業・研究者向けに、

LLM、画像生成、音声・映像処理などの生成AIモデル別に、推奨されるVRAM容量とGPUシステム選定の考え方を整理した実践ガイドです。

生成AIや画像生成、データ解析など、AI活用が業務や研究の現場で当たり前になりつつある今、AIを「どこで」「どのように」動かすか という点にも注目が集まっています。

クラウドAIが広く使われる一方で、近年は ローカル環境でAIを動かす「ローカルAI」 を選択する企業や研究者も増えてきました。

その背景には、コストだけでなく、セキュリティ面や応答速度、データ管理、運用の自由度といった、実運用に直結する理由があります。

こうしたローカルAIの活用を考える際に、多くの方が直面するのが

「このAIモデルを動かすには、どれくらいのVRAMが必要なのか?」という疑問です。

本記事では、ローカルAI・生成AIの実運用を前提に、

LLM、画像生成、音声・映像処理などで使われる代表的なAIモデルを取り上げ、

推奨されるVRAM容量やGPUやシステムの選定について分かりやすく解説します。

VRAMとは

VRAM(Video RAM)は、GPUが処理するAIモデルやデータを保持するための専用メモリです。

ローカルAIでは、モデル全体をVRAM上に展開する必要があるため、

VRAM容量がそのまま「動かせるAIモデルの規模」や「安定性」を左右します。

ローカルAI

ローカルAIとは、クラウドに依存せず、社内や拠点内の計算環境でAIモデルを実行する運用形態です。

対象となるAI処理は幅広く、

- LLM(テキスト生成)

- 画像生成

- 画像認識・解析

- 音声生成・音声認識

- 動画解析

など、多くの生成AIおよび推論処理がローカルAIの領域に含まれます。

クラウドAIだけでは不十分になりつつある理由

生成AIの利用が広がるにつれ、クラウドAIだけでは対応しきれない課題も明確になってきました。

コストの増大

大規模モデルの推論・学習は利用量に比例してコストが膨らみ、長期運用では負担になります。

レイテンシ(応答速度)

画像生成や動画解析などの重い処理では、クラウド経由の遅延が業務のボトルネックになります。

データガバナンス・セキュリティ

機密データを外部に出せない業務では、ローカル処理が不可欠です。

モデルの自由度

クラウドではモデル構成や最適化に制約があり、自社要件に合わせた運用が難しい場合があります。

こうした理由から、

クラウドとローカルを使い分ける「ハイブリッドAI運用」 が現実的な選択肢として注目されています。

ローカルAIのメリット

ローカルAIを導入することで、次のようなメリットがあります。

1. コスト最適化

長期運用では、クラウドの従量課金を抑えやすくなります。

2. 高速な処理

ローカル推論により、レイテンシを最小化できます。

3. セキュアなAI運用

機密データを外部に出さずにAI活用が可能です。

4. モデルの自由度

モデル選択・最適化・ファインチューニングを柔軟に行えます。

ローカルAIのデメリット(導入時の課題)

一方で、ローカルAIには次のようなハードルもあります。

- 初期投資(GPU・サーバー・電源・冷却)

- 運用管理の負荷(監視・アップデート・最適化)

- AIエンジニアリングの知識が必要

- モデルサイズによってはローカルで動作しないケース

これらの課題をどのように整理・対応するかが、ローカルAI導入の進めやすさや、運用の安定性に影響します。

ローカルAIで使われる代表的モデルと推奨VRAM一覧

ローカルAIを検討する際、最も多い質問が「このAIモデルは、どれくらいのVRAMが必要なのか?」です。

以下は、ローカル環境でよく使われるAIモデルと推奨VRAMの目安です。

※ 推論用途/一般的な構成を前提

※ 本記事のVRAM目安は、安定した長時間運用を想定した構成例です。

※ 実際に必要なVRAMは構成や最適化によって変わるため、余裕を持って選ぶことをおすすめします。

■生成AI(テキスト生成)

| モデル | パラメータ規模 | 推奨VRAM目安 | |

| Llama 3 8B | 約80億 | 16GB〜24GB | 実運用の定番 |

| Llama 3 70B | 約700億 | 80GB以上(マルチGPU) | 高精度・業務向け |

| Mistral 7B | 約70億 | 16GB | 軽量・高速 |

| Mixtral 8x7B | 約470億(MoE) | 48GB〜80GB | VRAM消費大 |

| Qwen2 7B | 約70億 | 16GB | 多言語対応 |

| Qwen2 72B | 約720億 | 80GB以上 | 高負荷構成 |

| Google Gemma 3 12B | 約120億 | 24GB〜32GB | 実用・RAG向き |

| Google Gemma 3 27B | 約270億 | 48GB〜80GB | 業務用途 |

| OpenAI gpt-oss-20B | 約200億 | 24GB〜32GB | OSS・商用検討向け |

| OpenAI gpt-oss-120B | 約1200億 | 80GB以上 | 大規模・研究用途 |

→ 小規模LLMはNVIDIA RTXクラスで対応可能

→ 業務利用・高精度用途では 大容量VRAMが重要

■RAG構成(Retrieval-Augmented Generation)

| 推奨要件 | |

| 生成AIモデル本体 | 16GB〜80GB |

| Embeddingモデル | + 4GB〜8GB |

| ベクトルDB | CPU+RAM依存 |

| 同時ユーザー対応 | 大容量VRAM GPU or 複数GPU |

→ RAGは GPU負荷が積み重なる構成

→ 長時間の安定稼働が重要

■画像生成(Stable Diffusion系)

| 推奨VRAM目安 | |

| Stable Diffusion 1.5 | 8GB〜12GB |

| Stable Diffusion XL | 16GB〜24GB |

| ControlNet併用 | 24GB以上 |

| LoRA学習 | 24GB〜48GB |

| DreamBooth学習 | 48GB以上 |

→ 高解像度・ControlNet併用でVRAM消費が急増

■画像認識・解析(Vision AI)

| 用途 | 推奨VRAM目安 |

| 物体検出(YOLO系) | 8GB〜16GB |

| セグメンテーション | 16GB〜24GB |

| 高精度解析・3D処理 | 24GB以上 |

→ 産業用途では連続稼働が前提

■音声・音楽生成(生成AI)

| 推奨VRAM目安 | |

| Whisper(音声認識) | 8GB〜16GB |

| Voice Conversion(RVC等) | 12GB〜24GB |

| MusicGen | 16GB〜24GB |

| Stable Audio系 | 24GB以上 |

→ バッチ処理・長時間生成で発熱が顕在化

一覧から見えてくる「ローカルAI運用の本質的な課題」・・・

この一覧から、次の事実が見えてきます。

- 多くのAIが24GB以上のVRAMを要求

- 複数用途を併用すると負荷が急増

- 実運用では長時間・高負荷が前提

つまり大切なのは、「動くか」より、「安心して長く使えるか」ではないでしょうか。

ローカルAI時代に求められるGPUシステムとは

ローカルAIを本格的に運用するには、単に「GPUを導入する」だけでは十分とは言えません。

LLM・画像生成・動画解析など用途に応じて、まずは十分なVRAM容量を確保することが重要です。

そのうえで、応答速度や同時処理を考慮した演算性能、将来の拡張を見据えたスケール構成が求められます。こうした要件を踏まえ、ローカルAI用途で検討されることの多いVRAM 24GB以上のGPUは下記となります。

生成AIを安心して動かすためのVRAM 24GB以上の推奨GPU

GPUの性能・詳細については各ページよりご確認ください。

※参考販売価格は変動する可能性がありますので、お見積をご依頼ください。

ワークステーションGPU

| GPUメモリ容量(VRAM) | 参考販売価格(税抜) | |

| NVIDIA RTX PRO 4000 Blackwell | 24GB | 302,000 円 |

| NVIDIA RTX PRO 4500 Blackwell | 32GB | 514,000 円 |

| NVIDIA RTX PRO 5000 Blackwell | 48GB | 896,000 円 |

| NVIDIA RTX PRO 6000 Blackwell Max-Q Workstation Edition | 96GB | 1,453,000 円 |

| NVIDIA RTX PRO 6000 Blackwell Workstation Edition | 96GB | 1,453,000 円 |

NVIDIA® RTX™ PROシリーズ 各GPUの性能・詳細はこちら

サーバーGPU

| GPUメモリ容量(VRAM) | 参考販売価格(税抜) | |

| NVIDIA RTX PRO 6000 Blackwell Server Edition | 96GB | 1,546,000 円 |

| NVIDIA H100 NVL | 94GB | 5,190,000 円 |

| NVIDIA H200 NVL | 141GB | 5,900,000 円 |

ローカルAIに適したGPUシステムの選び方

ローカルAI用途では、GPUのメモリ容量や性能だけでなく、設置環境や運用条件に応じたシステム選択が重要です。

以下は、環境別のGPUシステム構成例です。

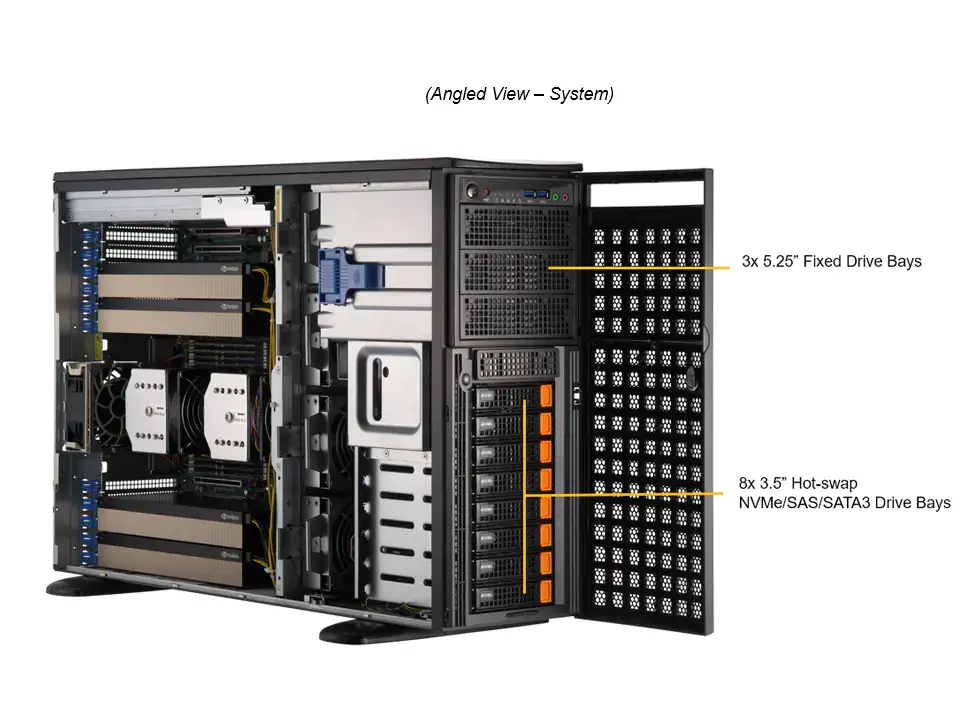

サーバー室・専用空調がある場合

サーバーGPU

+

筐体:サーバータイプ

サーバー室はないが、

VRAM容量の大きいGPUを使いたい場合

サーバーGPU

+

液冷GPUワークステーション「AquSysシリーズ」

オフィス設置・省電力を重視する場合

(RTX PROシリーズ中心)

ワークステーションGPU

+

筐体:ワークステーションタイプ

また、ローカルLLMやRAGをすぐに使いたい場合は、生成AIモデルをプレインストールしたGPU搭載ワークステーション「LLM/RAGシリーズ」もあります。オールインワンで、ローカル環境ですぐに生成AIを構築できます。

まとめ

ローカルAIの本格運用には、大容量VRAMと安定稼働を前提としたGPUシステム設計が不可欠です。

求められるのは「とりあえず動くGPU」ではなく、事業を支え続けられる信頼性の高いGPUシステムを選ぶことです。

GPUを選ぶ際は、VRAM容量だけでなく、冷却・静音・拡張性・運用性まで含めて検討することが大切です。