生成AI・大規模言語モデル・HPCを次の次元へ引き上げる次世代GPU

NVIDIA® H200 NVL 141GB は、HBM3eメモリとNVLink™を備え、生成AI・大規模言語モデル(LLM)・HPC向けに設計されたNVIDIA Hopper世代の最新GPUです。

NVIDIA® H200 NVL は、HBM3eメモリを141GB搭載した、生成AIおよびハイパフォーマンスコンピューティング(HPC)向けのGPUです。

大規模言語モデル(LLM)の学習・推論、科学シミュレーション、リアルタイム解析など、メモリ容量と帯域幅が性能を左右するワークロードにおいて、従来世代を大きく上回る性能を発揮 します。

※ 本製品は消費電力が非常に高いため、NVIDIAが認定したシステムでのみご利用いただけます。

動作確認済みのシステムや搭載方法については、弊社までお問い合わせください。

NVIDIA H200 NVL 主な特長

1. Hopper アーキテクチャの進化版

NVIDIA H200 は、Hopper アーキテクチャをベースに、AIトレーニング、推論、HPCアプリケーション向けに最適化されています。

前世代の H100 と比較して、メモリ容量とメモリ帯域幅が大幅に向上 し、より大規模なAIモデルやデータセットを効率的に処理可能です。

2. 141GB HBM3e メモリと 4.8TB/s の帯域幅

NVIDIA H200 は、HBM3e メモリを141GB 搭載した初のGPUです。

毎秒 4.8TB のメモリ帯域幅により、LLM や生成AI、HPC におけるメモリアクセスのボトルネックを解消します。

3. NVLink による高いスケーラビリティ

NVIDIA H200はNVLink™により最大4基のGPUを高速接続可能。

複数GPU構成でも、単一GPUのようにメモリを活用でき、大規模推論・分散処理に適しています。

4. 高性能と電力効率の両立

NVIDIA H200 は、H100 と同等の電力プロファイル内で、より高いパフォーマンスを実現します。消費電力あたりの性能が向上することで、AIファクトリーやデータセンター運用におけるトータルコスト(TCO)の削減 に貢献します。

5. 最適化されたAIワークロード

生成AIや大規模言語モデル(LLM)など、最先端のAIアプリケーション向けに設計されており、より高速なトレーニングと推論を可能にします。

参考販売価格:6,000,000円(税込 6,600,000円)

短期レンタル価格:978,000 円/月(税込 1,075,800 円/月)

長期1年レンタル価格:438,000 円/月(税込 481,800 円/月)

発売時期:2024年11月

レンタルの詳細はこちら

NVIDIA H200 NVL パフォーマンス

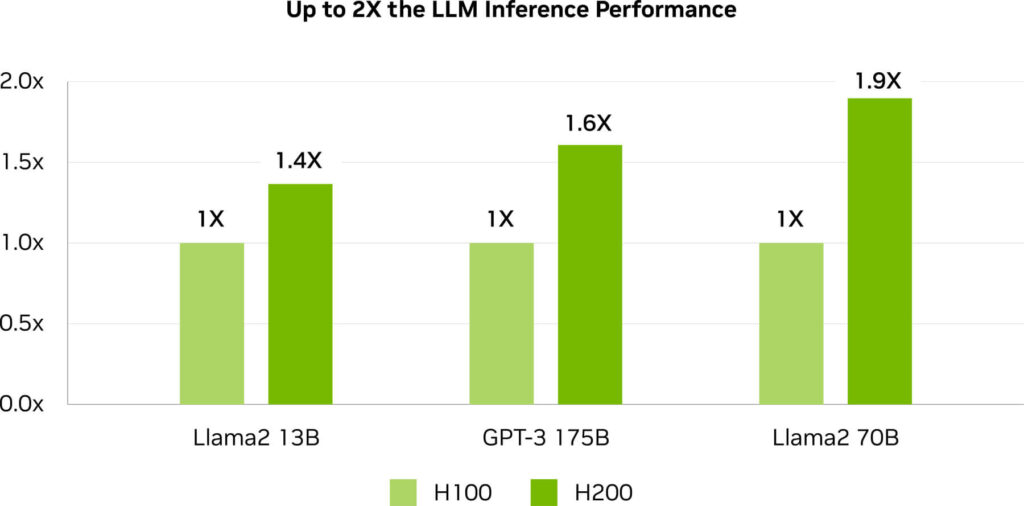

NVIDIA H200 は、H100 と比較して以下の性能向上を実現しています。

- LLM 推論性能:約1.6〜1.9倍

- メモリ容量:約2倍

- メモリ帯域幅:約1.4倍

GPT3-175B 推論 1.6倍 の高速化

LLama2 70B 推論 1.9倍 の高速化

参考仕様。変更される場合があります。

Llama2 13B: ISL 128, OSL 2K | Throughput | H100 SXM 1x GPU BS 64 | H200 SXM 1x GPU BS 128

GPT-3 175B: ISL 80, OSL 200 | x8 H100 SXM GPUs BS 64 | x8 H200 SXM GPUs BS 128

Llama2 70B: ISL 2K, OSL 128 | Throughput | H100 SXM 1x GPU BS 8 | H200 SXM 1x GPU BS 32.

大規模言語モデル(LLM)推論性能

NVIDIA H200 は、Llama2 などの LLM を扱う場合、H100 GPU と比較して 推論速度を約2倍に向上 させます。

企業における AI 推論では、高いスループットと最小限の TCO を両立することが重要です。

NVIDIA H200 は、大規模ユーザー向け推論基盤に最適なAI 推論アクセラレータです。

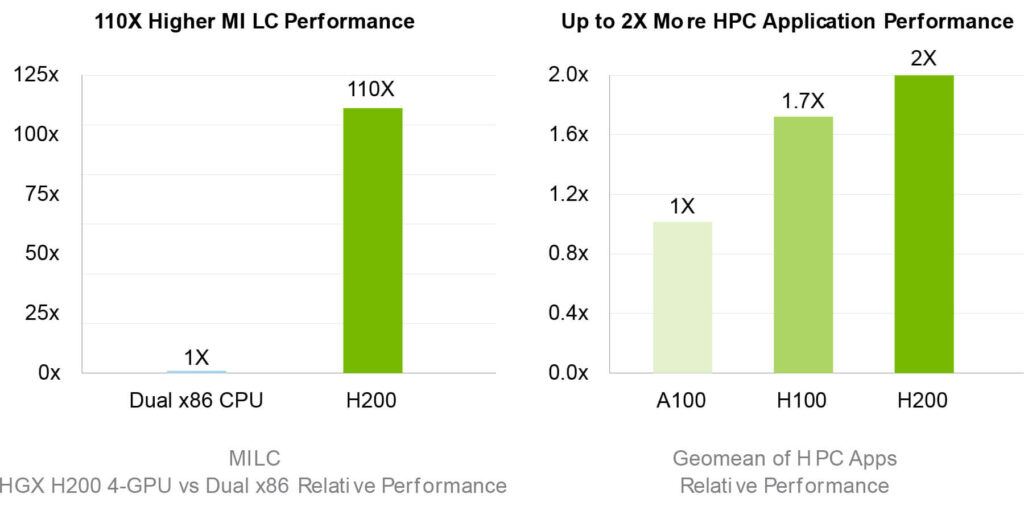

高性能コンピューティング(HPC):最大110倍の高速化

NVIDIA H200 は、メモリ帯域幅が性能を左右する HPC アプリケーションでは、CPU 構成と比較して最大110倍の高速化を実現します。

科学計算、分子動力学、量子化学、気象解析などの分野において、計算時間を大幅に短縮し、研究開発のスピードを加速します。

準備段階で測定されたパフォーマンスです。変更される可能性があります

HPC MILC- dataset NERSC Apex Medium | HGX H200 4-GPU | dual Sapphire Rapids 8480

HPC Apps- CP2K: dataset H2O-32-RI-dRPA-96points | GROMACS: dataset STMV | ICON: dataset r2b5 | MILC: dataset NERSC Apex Medium | Chroma: dataset HMC Medium | Quantum Espresso: dataset AUSURF112 | 1x H100 | 1x H200.

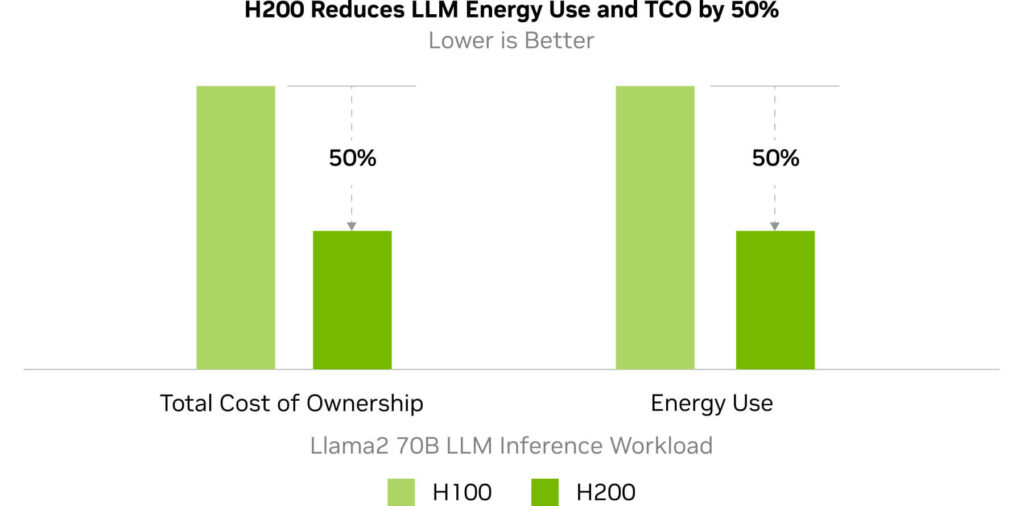

エネルギー効率とTCO削減

NVIDIA H200 は、高い演算性能と省電力設計を両立しています。

同一ワークロードあたりの消費電力を抑えることで、データセンター運用における電力コストと管理コストを削減します。

AIファクトリーやスーパーコンピューティングシステムにおいて、NVIDIA H200 は高速性だけでなく、経済性と持続可能性を兼ね備えたGPUです。

準備段階で測定されたパフォーマンスです。変更される可能性があります

Llama2 70B: ISL 2K, OSL 128 | Throughput | H100 1x GPU BS 8 | H200 1x GPU BS 32

NVIDIA H200 NVL 導入のメリット

最大限の生産性

圧倒的なスピードと効率性により、プロジェクトのスケジュールを短縮

長期的なコスト削減

エネルギー効率の向上により、運用コストを抑制

柔軟な拡張性

NVLinkにより、スケールアップが容易

NVIDIA H200 NVL とは

NVIDIA H200 NVL は、空冷式エンタープライズラック向けに最適化されたPCIeフォームファクターの GPUです。

最大4基のGPUを NVIDIA NVLink™ で接続可能で、

H100 NVL と比較して、

- LLM 推論性能:最大 約1.7倍

- HPC 処理性能:最大 約1.3倍

の性能向上を実現します。

柔軟な構成が求められる AI 基盤や HPC 環境において、高い導入性とパフォーマンスを両立します。

NVIDIA H200 NVL 性能・スペック

H100 NVL との性能・スペック比較

| NVIDIA H200 NVL 141GB | NVIDI H100 NVL94GB | |

| GPUアーキテクチャ | Hopper | Hopper |

| GPUメモリ | 141 GB HBM3e | 94 GB HBM3 |

| メモリバンド幅 | 4.8 TB/s | 3.9 TB/s |

| デコーダー | 7 NVDEC 7 JPEG | 7 NVDEC 7 JPEG |

| 最大熱設計電力(TDP) | 600W (configurable) | 300-350W (configurable) |

| マルチインスタンス GPUs | Up to 7 MIGs 16.5 GB each | Up to 14 MIGs 12 GB each |

| フォームファクター | PCIe Dual-slot / Air-cooled | PCIe Dual Slot / Air-cooled |

| 相互接続 | 2- or 4-way NVIDIA NVLink bridge: 900GB/s per GPU PCIe Gen5: 128GB/s | NVLink: 600 GB/s PCIe Gen5: 128 GB/s |

| FP64 | 30.0 TFLOPS | 34.0 TFLOPS |

| FP64 Tensor コア | 60.0 TFLOPS | 67.0 TFLOPS |

| FP32 | 60.0 TFLOPS | 67.0 TFLOPS |

| TF32 Tensor コア | 835 TFLOPS | 989 TFLOPS |

| BFLOAT16 Tensor コア | 1,671 TFLOPS | 1,979 TFLOPS |

| FP16 Tensor コア | 1,671 TFLOPS | 1,979 TFLOPS |

| FP8 Tensor コア | 3,341 TFOPS | 3,958 TFOPS |

| INT8 Tensor コア | 3,341 TFOPS | 3,958 TFOPS |

*仕様は変更される場合があります。

NVIDIA GPU 一覧表PDF

弊社で取り扱っているNVIDIA GPUの性能・スペックを一覧にしました。

PDFファイルをダウンロードすることができます。

よくある質問

Q1. NVIDIA H200 NVL はどのような用途に向いていますか?

生成AIや大規模言語モデル(LLM)の推論、およびメモリ帯域幅が性能を左右するHPC用途に最適です。特に、大規模モデルを少ないGPU構成で扱いたいケースに適しています。

Q2. NVIDIA H200 NVL と H100 NVL の違いは何ですか?

NVIDIA H200 NVL は、H100 NVL と同じ Hopper 世代のGPUですが、HBM3e メモリ(141GB)と 4.8TB/s の高帯域メモリを搭載している点が大きな違いです。

これにより、LLM 推論や HPC 処理において、H100 NVL 比で高い性能と効率を実現します。

Q3. NVIDIA H200 NVL はどのサーバーでも利用できますか?

いいえ。NVIDIA H200 NVL は消費電力が高いため、NVIDIA が認定した対応システムでのみ利用可能です。

対応サーバーや構成については、GDEPソリューションズまでお問い合わせください。

NVIDIA GPU 拡張保証サービス

NVIDIA GPUは「3年間センドバック保証(無償修理・交換)」のメーカー標準保証が基本として含まれていますが、

当社オリジナルとして「NVIDIA GPU 拡張保証サービス」をご提供しています。

「NVIDIA GPU 拡張保証サービス」には、先出しセンドバック保証、センドバック延長保証、オンサイト保証があり、お客様のニーズや状況にあわせた保証内容にすることができます。

NVIDIA GPU 拡張保証サービスにより、GPU導入後も、長く・安心してお使いいただけます。

GPUを導入される際に、あわせてご検討ください。

★NVIDIA GPU 拡張保証サービスの詳細はこちら

お気軽にご相談ください!

製品に関するご質問・ご相談など、お気軽にお問い合わせください。

NVIDIA認定のエリートパートナー「GDEPソリューションズ」は、

お客様の用途に最適な製品のご提案から導入までサポートします。