NVIDIA DGX™ B200 は、最新の Blackwell GPU を8基搭載した次世代の統合 AI プラットフォームです。2024年3月開催の NVIDIA GTC にて発表された Blackwell アーキテクチャに基づき、DGXシリーズの中でも最高クラスのAI・HPC性能を実現しています。

1,440GBという圧倒的なGPUメモリと、毎秒64TBのメモリ帯域幅により、生成AIや大規模言語モデル(LLM)、レコメンデーション、推論・トレーニングのワークロードを高速処理。前世代モデルと比較して、トレーニング性能は約3倍、推論性能は最大15倍に向上しています。

DGX B200 は、生成AIの導入を検討する企業や研究機関に最適な選択肢です。開発から本番運用まで、あらゆるAIパイプラインをサポートし、AIインフラの未来を支えます。

NVIDIA DGX B200

主な特徴

8 基の NVIDIA Blackwell GPUで構築

1.4TB(1,440GB)の GPU メモリ空間

72 ペタ FLOPS のトレーニング パフォーマンス

144 ペタ FLOPS の推論パフォーマンス

デュアル 第 5 世代 Intel® Xeon® スケーラブル プロセッサ搭載

NVIDIA AI Enterprise 、NVIDIA Base Command™ソフトウェアが含まれています

NVIDIA DGX B200

統合 AI プラットフォーム

~ 開発から展開までを支える単一のプラットフォーム ~

AI ワークフローが高度化するにつれて、トレーニングからファインチューンや推論に至る AI パイプラインの全ての段階で、企業が大規模なデータセットを処理する必要性も高

まっています。そのためには、膨大な計算処理能力が必要となります。

NVIDIA DGX B200 により、企業はワークフローを高速化するために構築された単一の統合プラットフォームで開発者・技術者を支援することができます。

次世代の生成 AI のために強化されたDGX B200 で、企業は日々の業務や顧客体験向上のためのAI 開発をさらに加速することが可能になります。

開発からデプロイまでのパイプラインのための

1 つのプラットフォーム

企業は、トレーニングからファインチューニング、推論まで、AI パイプラインのあらゆる段階で複雑な AI データセットを処理するために膨大な計算処理能力を必要とします。NVIDIA DGX B200 があれば、ワークフローを高速化するように作られた 1 つのプラットフォームを開発者に与えることができます。

究極の AI パフォーマンス

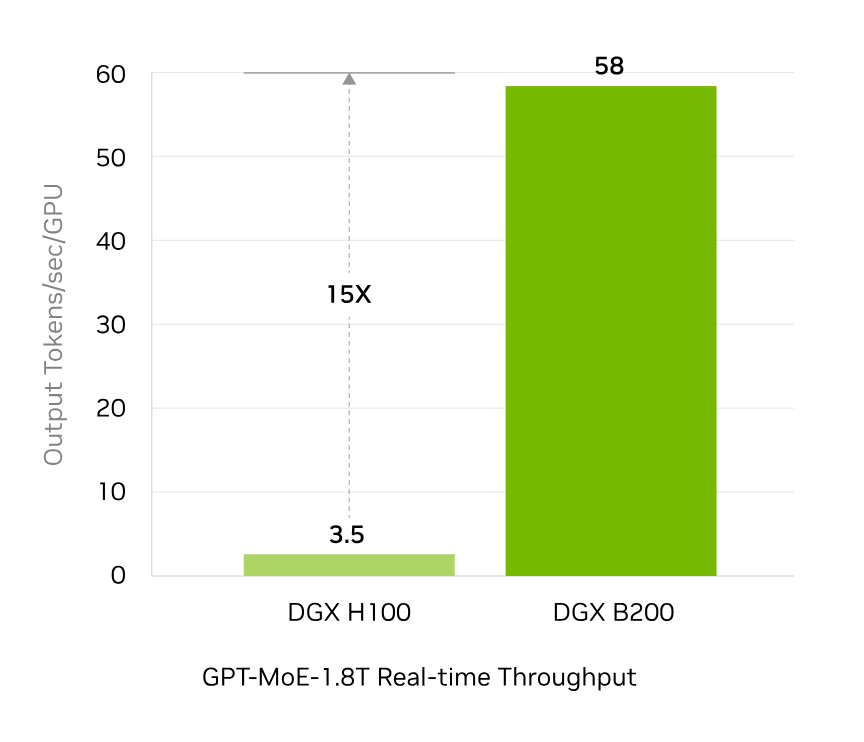

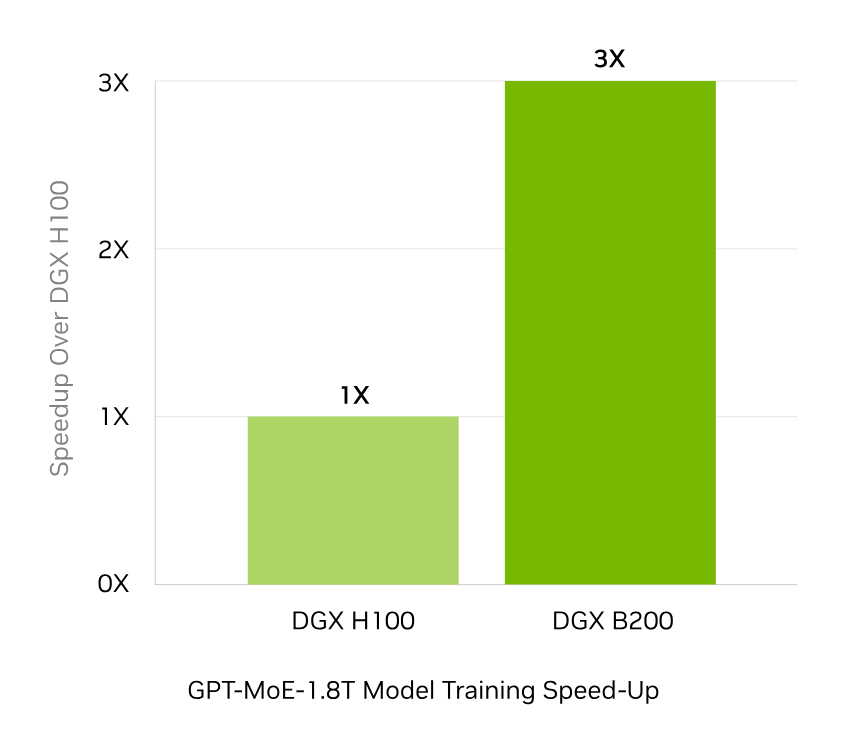

NVIDIA Blackwell アーキテクチャの高度なコンピューティングを活用する DGX B200 は、前世代となるDGX H100 と比較してそのトレーニング パフォーマンスが 3 倍、推論パフォーマンスが 15 倍となります。

NVIDIA DGX BasePOD™ や、NVIDIA DGX SuperPOD™ の土台である DGX B200 は、業界をリードするパフォーマンスをあらゆるワークロードに提供します。

実証済みのインフラストラクチャ標準

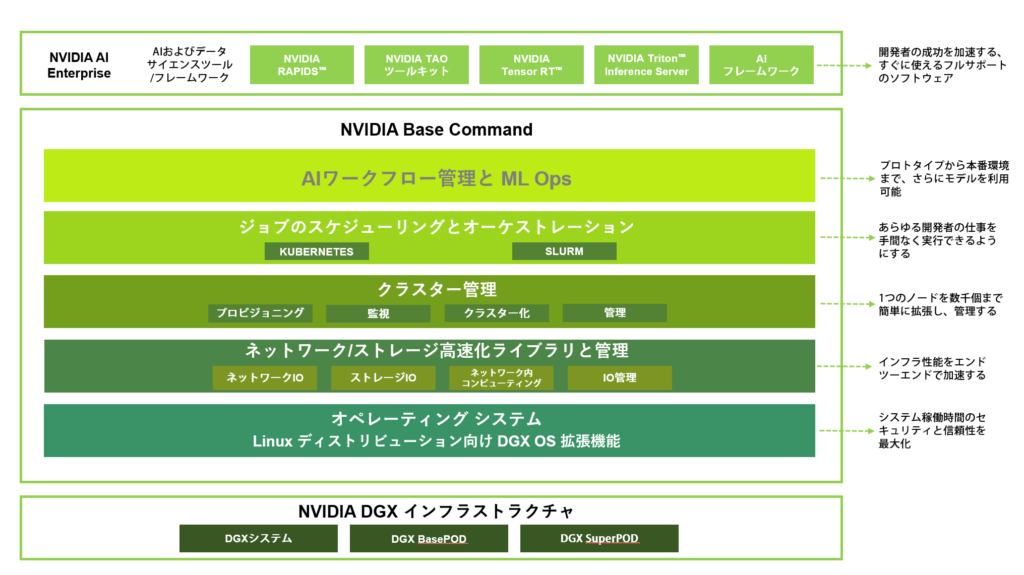

NVIDIA DGX B200 は、NVIDIA Base Command および NVIDIA AI Enterprise ソフトウェアを含む完全な NVIDIA AI ソフトウェア スタック、豊富なサードパーティ サポートのエコシステム、および NVIDIA プロフェッショナル サービスによる専門家のアドバイスへのアクセスを含む、完全に最適化されたハードウェアおよびソフトウェア プラットフォームです。

NVIDIA DGX B200

パフォーマンス

NVIDIA社は、企業が直面する最も複雑な AI 問題に対処するための、世界で最もパワフルな次世代スーパーコンピューターの設計に取り組んでいます。

DGX B200 はNVIDIA アクセラレーテッド コンピューティング プラットフォームの最新製品であり、その取り組みを示すものです。

革新的な NVIDIA Blackwell アーキテクチャによる高度なコンピューティングの進化により、DGX B200 は DGX H100 と比較してトレーニング性能が 3 倍、推論性能が 15 倍となります。NVIDIA DGX POD™ リファレンスアーキテクチャの基盤である DGX B200 は NVIDIA DGX BasePOD™ と NVIDIA DGX SuperPOD™ を支える優れた高速性と拡張性を提供し、手間のかからない AIインフラ ソリューションで最高レベルのパフォーマンスを実現します。

リアル タイム

大規模言語モデル推論

予想されるパフォーマンスは変更される可能性があります。

トークン間のレイテンシ (TTL) = 50ms リアルタイム、最初のトークンのレイテンシ (FTL) = 5ms、入力シーケンスの長さ = 32,768、出力シーケンスの長さ = 1,028、8x 8ウェイ HGX H100 GPU 空冷と 1x 8ウェイ DGX B200 空冷の比較、GPU あたりのパフォーマンス比較。

大幅に強化された

AIトレーニング性能

予想されるパフォーマンスは変更される可能性があります。

32,768 GPU スケール、4,096x 8ウェイ DGX H100 空冷クラスター: 400G IB ネットワーク、4,096x 8ウェイ DGX B200 空冷クラスター: 400G IB ネットワーク。

NVIDIA DGX B200

実証済みインフラ標準 / NVIDIA Base Command 搭載

NVIDIA DGX B200 は、NVIDIA Blackwell GPU を搭載した世界初のシステムであり、大規模言語モデルや自然言語処理など、世界で最も複雑な AI 問題を処理するための画期的なパフォーマンスを提供します。

NVIDIA DGX B200 は、完全に最適化されたハードウェアおよびソフトウェア のプラットフォームです。

NVIDIA AI ソフトウェアのフルスタックを備え、多様なサードパーティのサポートを受けられる充実したエコシステムを利用でき、さらに NVIDIA プロフェッショナル サービスにより専門家からのアドバイスを受けることができます。

組織は AI を利用し、最大かつ最も複雑なビジネス問題を解決できます。

NVIDIA Base Command 搭載

NVIDIA Base Command は DGX プラットフォームを強化し、NVIDIA ソフトウェアがもたらすイノベーションを企業が最大級活用できるようにします。企業は、エンタープラ

イズグレードのオーケストレーションとクラスター管理、コンピューティング、ストレージ、ネットワークのインフラを高速化するライブラリ、AI ワークロード向けに最適化されたオ

ペレーティング システムを含む実証済みのプラットフォームで、DGX インフラの可能性を最大限まで引き出すことができます。

また、DGX インフラには、AI の開発と展開を効率化するために最適化された一連のソフトウェア、NVIDIA AI Enterprise も含まれています。

NVIDIA DGX B200 スペック

NVIDIA DGXシリーズ「NVIDIA DGX B200」、「NVIDIA DGX H200」、「NVIDIA DGX H100」のスペックを比較してみましょう。

| NVIDIA DGX B200 | NVIDIA DGX H200 | NVIDIA DGX H100 | |

| GPU | NVIDIA Blackwell GPU × 8基 | NVIDIA H200 Tensor Core GPU × 8基 | NVIDIA H100 Tensor Core GPU × 8基 |

| GPUメモリ | Total 1,440 GB | Total 1,128 GB | Total 640 GB |

| 性能 | 72 petaFLOPSトレーニング 144 ペタ FLOPS 推論 | 32 petaFLOPS FP8 | 32 petaFLOPS FP8 |

| NVIDIA NVSwitches | 2 | 4 | 4 |

| CPU | Dual Intel® Xeon® Platinum 8570 プロセッサ (合計 112 コア)、2.1 GHz (ベース)、 4 GHz (最大ブースト) | Dual Intel® Xeon® Platinum 8480C プロセッサ (合計112コア、2.0 GHz (ベース)、3.8 GHz (最大ブースト) | Dual Intel® Xeon® P latinum 8480C プロセッサ(合計 112 コア)、2.0 GHz (ベース)、3.8 GHz(最大ブースト) |

| システムメモリ | 4 TB | 2 TB | 2 TB |

| ネットワーク | 4 個の OSFP ポートで 8 個のシングルポートNVIDIA ConnectX-7 VPI > 400 Gb/秒の InfiniBand/Ethernet 2 基のDual-Port QSFP112 NVIDIA BlueField-3 DPU > 400 Gb/秒の InfiniBand/Ethernet 10 Gb/秒 オンボード NIC (RJ45 搭載) 100 Gb/秒のDual-Port Ethernet NIC ホスト ベースボード管理コントローラー (B M C)(RJ 45 搭載) | 4 個の OSFP ポートで 8 基のシングル ポート NVIDIA ConnectX-7 VPI > 400 Gb/秒の InfiniBand/Ethernet 2 基のDual-Port QSFP112 NVIDIA ConnectX-7 VP I > 400 Gb/秒のInfiniBand/Ethernet 10 Gb/秒 オンボード NIC(RJ 45 搭載) 100 Gb/秒のEthernet NIC ホスト ベースボード管理コントローラー (BMC)(RJ 45 搭載) | 4 個の OSFP ポートで 8 基のシングル ポート NVIDIA ConnectX-7 VPI > 400 Gb/秒の InfiniBand/Ethernet 2 基のDual-Port QSFP112 NVIDIA ConnectX-7 VP I > 400 Gb/秒のInfiniBand/Ethernet 10 Gb/秒 オンボード NIC(RJ 45 搭載) 100 Gb/秒のEthernet NIC ホスト ベースボード管理コントローラー (B M C)(RJ 45 搭載) |

| ストレージ | OS: 1.92 TB M.2 NVMe drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives | OS: 1.9 TB M.2 NVMe drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives | OS: 1.92 TB M.2 NVMe E drives × 2 内部ストレージ: 30 TB (3.84 TB × 8) U.2 NVMe drives |

| ソフトウェア | NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command - オーケストレーショ ン、スケジューリング、クラスタ管理 DGX OS / Ubuntu | NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command - オーケストレーショ ン、スケジューリング、クラスタ管理 DGX OS / Ubuntu / Red HatエンタープライズLinux / Rockyオペレーティングシステム | NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command - オーケストレーショ ン、スケジューリング、クラスタ管理 DGX OS / Ubuntu |

| 最大消費電力 | 最大 14.3 kW | 最大 10.2 kW | 最大 10.2 kW |

| 運用温度範囲 | 5 ℃ - 30 ℃ | 5 ℃ - 30 ℃ | 5 ℃ - 30 ℃ |

| サイズ | 高さ: 442 mm 幅: 482.6 mm 奥行: 907.8 mm 142.38 kg | 高さ: 356mm 幅: 482.2mm 奥行: 897.1mm 130.45kg | 高さ:356 mm 幅:482.2 mm 奥行:897.1 mm 130.45 kg |

企業向けサポート

・ハードウェアとソフトウェアの 3 年間のエンタープライズ Business-Standardサポート

・年中無休のエンタープライズ サポート ポータル アクセス

・現地営業時間中のライブ エージェント サポート

* スペックは予告なく変更される場合があります。

NVIDIA DGX B200 カタログ

NVIDIA DGX B200 のカタログをダウンロードできます。

NVIDIA DGX B200 価格

教育機関、NVIDIA Inceptionパートナー、一般企業・研究機関向けの価格がございます。

また、3年間の企業向けサポートのご購入が必要になります。

(サポート期間は4年、5年も選択可能です。)

詳しくはお問い合わせ下さい。

★ 出荷開始までにスペック、価格、サポート内容等は変更される場合があります。ご了承ください。

見積依頼・お問い合わせはこちら

製品に関するご質問・ご相談など、お気軽にお問い合わせください。

NVIDIA認定のエリートパートナー「GDEPソリューションズ」は、

お客様の用途に最適な製品のご提案から導入までサポートします。