株式会社朝日新聞社 / メディア研究開発センター

次長 / 博士(情報科学)

田森 秀明 氏

2022年12月

AIを使った音声入力や校正・編集の自動化が進んでいます。

同様のテクノロジーは世界各国で盛んに研究されていますが、日本語は特に複雑かつ多様な分、精度を上げるために多くのリソースが使われています。

朝日新聞社はその中でも、良質な日本語のデータ量では国内でもトップレベルにあり、同社にしかできない、強みを持ったAI製品開発を続けている田森様にお話を伺いました。

膨大な日本語データを活用

株式会社朝日新聞社(以降、朝日新聞社)は、日本になくてはならないニュースメディアとして広く知られている企業です。

新聞はもちろん、Web上のニュース媒体「朝日新聞デジタル」の提供も行っています。

グループ会社にはテレビ局もあり、地上波はもちろん、動画配信等を含めた総合メディア企業として、日々の出来事や世界中の変化を広く私たちに届けてくれています。

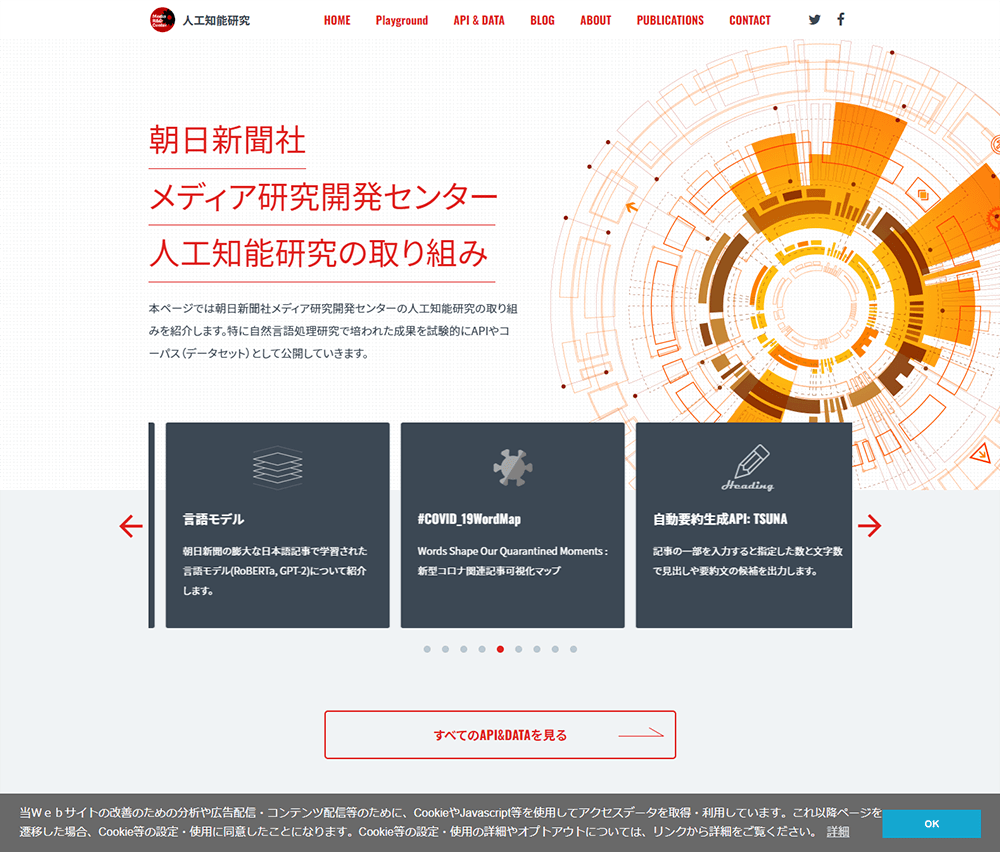

そんな朝日新聞社のメディア研究開発センターでは人工知能(AI)研究が盛んにおこなわれています。

「様々な形で取り組みを続けていますが、自然言語処理や音声、画像処理などを行うAIの開発、データ分析を活用したデータジャーナリズムなどをメインに、我々の業務改革はもちろん、朝日新聞社にしかできないような強みを持った製品を社会に届けるための研究をしています」と田森氏。

日本有数の新聞社ということもあり、同社が保有するテキストや画像の量は他社の追随を許しません。

その豊富なデータを活用して研究開発されるサービスには、あらゆる業界が視線を注いでいます。

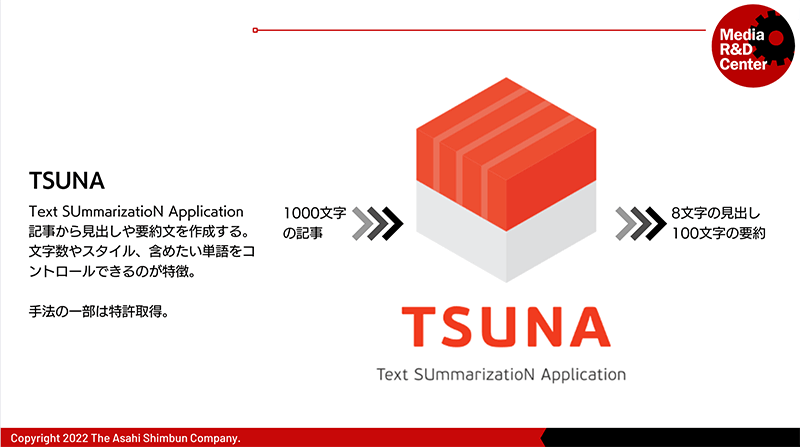

「例えば自動要約生成APIの『TSUNA』は記事の本文をそのまま入力するだけで、指定した文字数の要約文を作るサービスです。

例えば新幹線の車内テロップでみなさんがご覧になるような短文ニュースが簡単に作成できるようになります」と解説する田森氏。

これによって短文ニュース制作の労力が従来と比較して1/90になったそうです。

実際の記事を使った実験では、編集者が付与した見出しと比較しても、どちらがTSUNAによるものかがほとんど分からないという評価が得られています。

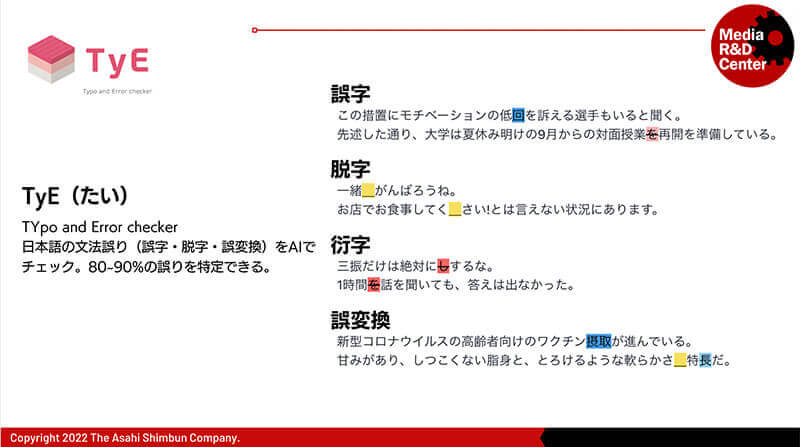

もうひとつ実現しているサービスが文章校正支援APIの『TyE』です。

新聞製作の過程で発生する校閲に関するデータを収集し、AIの学習に活かしました。

「このサービスは文章の中の間違っていそうな部分を、誤りのルール辞書を作成せずとも指摘してくれます。あえて修正候補を出さないようにすることで速度と精度を向上させています」と田森氏。

現時点での修正箇所の発見率は80%と高いですが、AIは現在も学習を続けているので、その精度はさらに高まっていきます。

そのほか、データジャーナリズムではTwitterや過去記事からその傾向を導き出したり、選挙における各党首の演説の変化を分析したりするなど、新聞社らしい多様な視点からの解析をAIでサポートできるような仕組みの研究が続いています。

前環境と比較し最大3倍の高速化

自社が持つ膨大な文章データを使った研究にはハイパフォーマンスなコンピューターが必須です。

「ちょうどディープラーニングが注目され始めた2016年頃から、GPUを使ったAI研究が始まりました。すぐに私たちもサーバーを導入しましたが、研究がどんどん高度化していく中で、パフォーマンスやリソースも膨れ上がっていきました。

毎年という訳ではありませんが、頻繁にサーバーの入れ替えや増強を行ってきました」と田森氏は振り返ります。

そんな同社が最近導入したのが「GS-Supermicro 420GP-TNR」です。

4Uサイズのサーバーで最大で10基のGPUを搭載できます。

「今回はNVIDIA A100 Tensor コア GPUを採用しました。とてもパワフルで、大幅に開発作業の効率化が実現できています」と田森氏。

これまでのサーバーと比較し、あらゆる作業で2~3倍の高速化となっているといいます。

「ですから、このサーバーに関してはメンバーの間で予約の奪い合いになっています(笑)」と田森氏は導入の手応えを語ります。

一方で田森氏は単純なパフォーマンスだけならクラウドサービスを使うだけでも良いと言い切ります。

「ハイレベルなパフォーマンスが必要なら、クラウドサービスでもリソースは簡単に調達できます。しかし、オンプレミスでサーバーを持つメリットは単純な演算処理の高速化だけでなく、研究メンバーのモチベーション向上にもあると思っています」(田森氏)。

AI開発にトライアンドエラーは不可欠ですが、クラウドサービスを使って多大なリソースを使うには大きなコストが必要です。

そのうえで、試行が失敗するかもしれないとなると、開発者の心理にも大きな影響が出ます。

「1回の試行にクラウドの利用料が50万円かかる場合、それを5回やりたいとなると250万円の予算が必要です。

それでも成果が得られない可能性もあるのがAI開発ですから、クラウドサービスの利用の際の研究メンバーは常にプレッシャーを感じているのです。

それで試行する回数を減らしたり、トライする機会に遠慮が出たりするのはメンバーにとって大きなマイナスです。

オンプレミスでトライアンドエラーを繰り返しても費用を気にせずに済みますし、失敗を恐れず試行を続けることが可能です。

クラウドサービスにも良いところがたくさんありますから、そちらは開発後のファインチューンなど失敗があまりないカスタマイズに使っていけばいい。使い分けが肝心ですね。」と田森氏は語ります。

研究者の視点も考慮することでオンプレミスサーバーを最大限に活用する。これが田森氏流のサーバー活用術なのかもしれません。

AI活用をさらに拡大

「NVIDIA A100 Tensor コア GPU」を搭載した「GS-Supermicro 420GP-TNR」の導入で、開発にも弾みがついているメディア研究開発センター。

実はストレージシステムにも一つ工夫をしたそうです。

「ストレージ管理に『PLIOPS Xtreme Data Processor(XDP)』を導入しました。

現在のデータストレージにも満足はしているのですが、開発が進む中でどうしてもデータは肥大化していきます。

そこでXDPを導入してデータの効率的な圧縮効果とRAID5による安定した運用を実現したいと考えました」と田森氏。

AIの研究中に1TBのデータを使ったとすれば、同じ研究を重ねるごとに2TB、3TBとすぐに容量が増えます。

膨大な容量を持つデータサーバーであっても、研究に没頭する中で不意に「Disk Full」のアラートが出てしまうこともあります。

独自の圧縮技術を提供するXDPがあれば、ストレージの最適化と効率運用が可能になるというわけです。

「こちらの効果はまだこれから出てくるという段階ですが、狙った効果が出るよう大きく期待しています」と田森氏は笑顔で語ります。

「今後は音声認識入力支援サービスや、自動要約生成APIの『TSUNA』の動画版のようなサービス開発も進めています。

どちらも既存のサービスがありますが、私たちでないと実現できない機能もたくさんあるので、弊社らしい製品づくりを目指しています」と最後に田森氏は展望を語ってくださいました。

GDEPソリューションズはこれからも朝日新聞社をサポートしていきます。

取材:GDEPソリューションズ株式会社

協力:菱洋エレクトロ株式会社

GPU導入事例 朝日新聞社様

導入製品はこちら!

NVIDIA A100 Tensor Core GPU

NVIDIA A100 GPU は、コアアーキテクチャに多くの改良を加え、前世代(NVIDIA V100)と比較して最大 20 倍のパフォーマンスを発揮し、新しいスパース性機能を使うことにより、そこからさらに2倍の高速化を実現しました。

単精度・倍精度演算性能の両方を兼ね備え、ディープラーニング、HPC(ハイパフォーマンスコンピューティング)、データサイエンス、シミュレーションなど、大規模な計算において、最大のパフォーマンスを発揮します。